Google Cloud アーキテクチャ フレームワークは、アーキテクト、デベロッパー、管理者、およびその他のクラウドの実務担当者が、安全で効率的、復元性が高く、高パフォーマンスで費用対効果に優れたクラウド トポロジを設計および運用するためのベスト プラクティスと最適化案を提供します。Google Cloud アーキテクチャ フレームワークは、Google Cloud による適切に設計されたフレームワークです。

Google の複数の部門にまたがるエキスパートのチームが、アーキテクチャ フレームワークを構成する設計の最適化案とベスト プラクティスを検証します。チームがアーキテクチャ フレームワークをキュレートし、Google Cloud の拡張機能、業界のベスト プラクティス、コミュニティの知識、ユーザーからのフィードバックを反映させます。主な変更の概要については、最新情報をご覧ください。

アーキテクチャ フレームワークの設計ガイダンスは、クラウド用に構築されたアプリケーションと、オンプレミスから Google Cloud に移行されたワークロード、ハイブリッド クラウドのデプロイメント、マルチクラウド環境に適用されます。

次の図に示すように、Google Cloud アーキテクチャ フレームワークは 6 つのカテゴリ(別名柱)に編成されています。

- システム設計

- このカテゴリは、Google Cloud アーキテクチャ フレームワークの基盤を構成するものです。クラウド システムの要件を満たすために必要なアーキテクチャ、コンポーネント、モジュール、インターフェース、データを定義し、システム設計をサポートする Google Cloud のプロダクトと機能について確認します。

- オペレーショナル エクセレンス

- クラウド ワークロードを効率的にデプロイ、運用、モニタリング、管理します。

- セキュリティ、プライバシー、コンプライアンス

- クラウド内のデータとワークロードのセキュリティを最大化し、プライバシーを考慮した設計を行い、規制要件と標準に対応します。

- 信頼性

- クラウドで復元性と高可用性を備えたワークロードを設計し、運用します。

- 費用の最適化

- Google Cloud への投資のビジネス上の価値を最大化します。

- パフォーマンスの最適化

- パフォーマンスが最適化されるようにクラウド リソースを設計、調整します。

Google Cloud プロダクトの概要とそれらの相互関係の仕組みについては、Google Cloud のプロダクト、機能、サービスを簡潔に説明をご覧ください。

Google Cloud アーキテクチャ フレームワーク: システム設計

システム設計は、Google Cloud アーキテクチャ フレームワークの基礎となるカテゴリです。このカテゴリでは設計に関する推奨事項を提示し、クラウド プラットフォームのアーキテクチャ、コンポーネント、モジュール、インターフェース、データを定義して、システム要件を満たすためのベスト プラクティスと原則について説明します。また、システム設計をサポートする Google Cloud のプロダクトと機能についても説明します。

システム設計カテゴリのドキュメントでは、基本的なシステム設計の原則を理解していることを前提としています。クラウドのコンセプトと Google Cloud プロダクトに関する知識があることは前提としていません。

複雑なクラウドの移行とデプロイのシナリオでは、Google Cloud コンサルティング サービスの利用をおすすめします。Google のコンサルタントがベスト プラクティスと指針についての専門知識を提供し、お客様のクラウド移行の成功を支援します。Google Cloud にはパートナーの強力なエコシステムもあります。大規模なグローバル システム インテグレータから ML のような特定分野を専門とするパートナーまで、さまざまなパートナーが参加しています。デジタル トランスフォーメーションを加速し、ビジネスの成果の向上のために、Google Cloud パートナーと連携することをおすすめします。

アーキテクチャ フレームワークのシステム設計カテゴリーでは、次の方法を学びます。

- システム設計の基本原則を適用する。

- ビジネス アプリケーションをサポートする地理的なリージョンを選択する。

- クラウド リソースを管理する。

- コンピューティングを選択して管理する。

- ネットワーク インフラストラクチャを設計する。

- ストレージ戦略を選択して実装する。

- データベースを最適化する。

- データを分析する。

- ML を導入する。

- サステナビリティを考慮したクラウド ワークロードを設計する。

システム設計の基本原則

Google Cloud アーキテクチャ フレームワークのこのドキュメントでは、システム設計の基本原則について説明します。堅牢なシステム設計とは、安全性、信頼性、拡張性、独立性を備えたものです。これにより、システムを停止することなく、反復と取り消しが可能な変更を行い、潜在的なリスクを最小限に抑え、運用効率を向上させることができます。堅牢なシステム設計を実現するには、以下の 4 つの基本原則に沿うことをおすすめします。

すべてを文書化する

ワークロードのクラウドへの移行やアプリケーションの構築を開始する際に、システムのドキュメントが不足していることが成功を妨げる主な要因となります。現在のデプロイのアーキテクチャを正しく可視化するには、ドキュメントが特に重要です。

クラウド アーキテクチャを適切に文書化することで、共通の言語と標準が確立され、部門横断的なチーム間でのコミュニケーションとコラボレーションを効果的に行いやすくなります。また、将来的な設計上の意思決定を促し、指針にするために必要な情報も提供します。設計上の意思決定に対応する内容を提供するため、ユースケースを念頭に置いてドキュメントを作成する必要があります。

時間の経過とともに、設計上の意思決定は進化、変化していきます。変更履歴があれば、チームが構想を調整し、重複を避け、時間の経過に沿ったパフォーマンスの変化を効果的に測定するために必要な背景情報が得られます。現在のシステム設計、戦略、過去の経緯をよく理解していない新しいクラウド アーキテクトをオンボーディングする場合、変更ログは特に役立ちます。

設計を簡素化し、フルマネージド サービスを利用する

システム設計にはシンプルさが重要です。アーキテクチャが複雑すぎて理解しにくい場合、設計を実装して時間の経過とともに管理することが難しくなります。可能であれば、フルマネージド サービスを使用して、ベースライン システムの管理とメンテナンスに伴うリスク、時間、労力を最小限に抑えてください。

本番環境ですでにワークロードを実行している場合は、マネージド サービスでテストして、運用の複雑さがどのように軽減されるかをご確認ください。新しいワークロードを開発している場合は、単純なものから最小実装製品(MVP)を確立して、オーバー エンジニアリングへの抵抗感を和らげてください。特殊なユースケースを特定し、イテレーションを行い、時間をかけて段階的にシステムを改善していくことができます。

アーキテクチャを分離する

分離とは、アプリケーションやサービス コンポーネントを、独立して動作できる小さなコンポーネントに分離するために使用される手法です。たとえば、モノリシック アプリケーション スタックを個別のサービス コンポーネントに分割できます。分離されたアーキテクチャでは、さまざまな依存関係に関係なく、アプリケーションは機能を個別に実行できます。

アーキテクチャを分離することで、柔軟性が向上し、次のことが可能になります。

- 独立したアップグレードを適用する。

- 特定のセキュリティ管理を実施する。

- サブシステムごとに信頼性の目標を設定する。

- 正常性をモニタリングする。

- パフォーマンスとコストのパラメータをきめ細かく制御する。

分離は、設計段階早期から始めることも、規模の拡大に伴うシステム アップグレードの一部として行うこともできます。

ステートレス アーキテクチャを使用する

ステートレス アーキテクチャでは、アプリケーションの信頼性とスケーラビリティの両方を向上させることができます。

ステートフル アプリケーションは、ローカルのキャッシュに保存されたデータなど、さまざまな依存関係を使用してタスクを実行します。ステートフル アプリケーションでは、多くの場合、進捗状況をキャプチャして正常に再起動するための追加のメカニズムが必要です。ステートレス アプリケーションは、共有ストレージやキャッシュ サービスを使用することで、ローカルの依存関係をさほど利用することなくタスクを実行できます。ステートレス アーキテクチャを使用すると、ブート依存関係を最小限に抑え、アプリケーションを迅速にスケールアップできます。アプリケーションは強制的な再起動に耐え、ダウンタイムを短縮し、エンドユーザーのパフォーマンスを高めることができます。

システム設計のカテゴリでは、アプリケーションをステートレスにするための推奨事項、すなわちステートフル アプリケーションのためのマシン状態の取得を改善するためにクラウドネイティブの機能を利用する方法について説明しています。

次のステップ

- ビジネス アプリケーションをサポートする地理的なリージョンを選択する。

- クラウド リソースを管理する。

- コンピューティングを選択して管理する。

- ネットワーク インフラストラクチャを設計する。

- ストレージ戦略を選択して実装する。

- データベースを最適化する。

- データを分析する。

- ML を導入する。

- サステナビリティを考慮したクラウド ワークロードを設計する。

Google Cloud デプロイ アーキタイプを選択する

Google Cloud アーキテクチャ フレームワークのこのドキュメントでは、6 つのデプロイ アーキタイプ1(ゾーン、リージョン、マルチリージョン、グローバル、ハイブリッド、マルチクラウド)について説明します。これらを使用して、可用性、コスト、パフォーマンス、運用効率の要件に基づいてクラウド ワークロード用のアーキテクチャを構築できます。

デプロイ アーキタイプとは

デプロイ アーキタイプは、プロバイダに依存しない抽象化されたモデルです。これを基盤として使用することにより、ビジネス要件と技術要件を満たすアプリケーション固有のデプロイ アーキテクチャを構築できます。各デプロイ アーキタイプは、アプリケーションを実行できる障害発生ドメインの組み合わせを表します。これらの障害発生ドメインは 1 つ以上の Google Cloud ゾーンまたはリージョンにすることができます。また、オンプレミス データセンターや他の障害発生ドメインが含まれるように拡張することもできます。

次の図は、Google Cloud にデプロイされた 6 つのアプリケーションを示しています。各アプリケーションは、特定の要件を満たすデプロイ アーキタイプを使用します。

上の図に示すように、ハイブリッドまたはマルチクラウドのデプロイ アーキタイプを使用するアーキテクチャは、クラウド トポロジはゾーン、リージョン、マルチリージョン、またはグローバルの基本アーキタイプのいずれかをベースにしています。この意味で、ハイブリッド デプロイとマルチクラウド デプロイ アーキタイプは、基本的なアーキタイプの一つを含む複合型のデプロイ アーキタイプと考えることができます。

デプロイ アーキタイプを選択すると、使用すべき Google Cloud プロダクトと機能に関するその後の決定を簡単に行うことができます。たとえば、高可用性のコンテナ化されたアプリケーションで、リージョン デプロイ アーキタイプを選択した場合は、ゾーン GKE クラスタよりもリージョン Google Kubernetes Engine(GKE)クラスタのほうが適切な選択肢となります。

アプリケーションのデプロイ アーキタイプは、可用性、費用、運用の複雑さなどのトレードオフを考慮して選択する必要があります。たとえば、アプリケーションが複数の国のユーザーにサービスを提供し、かつ高可用性が求められる場合は、マルチリージョン デプロイ アーキタイプを選択します。一方、単一リージョンの従業員が使用する内部アプリケーションの場合は、可用性よりもコストを優先し、リージョン デプロイ アーキタイプを選択したほうがかもしれません。

デプロイ アーキタイプの概要

以下のタブでは、各デプロイ アーキタイプの定義と、ユースケースの概要および設計上の考慮事項について説明します。

ゾーン

次の図に示すように、アプリケーションは単一の Google Cloud ゾーン内で実行されます。

| ユースケース |

|

|---|---|

| 設計上の考慮事項 |

|

| 詳細 | 次のセクションをご覧ください。 |

リージョン

次の図に示すように、アプリケーションは単一の Google Cloud リージョン内の複数のゾーンで独立して実行されます。

| ユースケース |

|

|---|---|

| 設計上の考慮事項 |

|

| 詳細 | 次のセクションをご覧ください。 |

マルチリージョン

アプリケーションは、2 つ以上の Google Cloud リージョンの複数のゾーンで独立して実行されます。DNS ルーティング ポリシーを使用して、受信トラフィックをリージョン ロードバランサにルーティングできます。次の図に示すように、リージョン ロードバランサは、トラフィックをアプリケーションのゾーンのレプリカに分散します。

| ユースケース |

|

|---|---|

| 設計上の考慮事項 |

|

| 詳細 | 次のセクションをご覧ください。 |

グローバル

アプリケーションは、グローバルに分散された(ロケーション非認識の)スタックまたはリージョンに分離されたスタックとして、世界中の Google Cloud リージョンで実行されます。グローバル エニーキャスト ロードバランサが、ユーザーに最も近いリージョンにトラフィックを割り当てます。アプリケーション スタックの他のコンポーネント(データベース、キャッシュ、オブジェクト ストアなど)もグローバルにできます。

次の図は、グローバル デプロイ アーキタイプの、グローバルに分散されたバリアントを示しています。グローバル エニーキャスト ロードバランサは、複数のリージョンに分散され、グローバルに複製されたデータベースを使用するアプリケーション スタックにリクエストを転送します。

次の図は、リージョンに分離されたアプリケーション スタックでのグローバル デプロイ アーキタイプのバリアントを示しています。グローバル エニーキャスト ロードバランサは、いずれかのリージョンのアプリケーション スタックにリクエストを転送します。すべてのアプリケーション スタックは、グローバルに複製された単一のデータベースを使用します。

| ユースケース |

|

|---|---|

| 設計上の考慮事項 | クロスリージョンのデータ転送とデータ レプリケーションのコスト。 |

| 詳細 | 次のセクションをご覧ください。 |

ハイブリッド

次の図に示すように、アプリケーションの特定の部分は Google Cloud にデプロイされ、他の部分はオンプレミスで実行されます。Google Cloud のトポロジでは、ゾーン、リージョン、マルチリージョン、またはグローバルのデプロイ アーキタイプを使用できます。

| ユースケース |

|

|---|---|

| 設計上の考慮事項 |

|

| 詳細 | 次のセクションをご覧ください。 |

マルチクラウド

次の図に示すように、アプリケーションの一部は Google Cloud にデプロイされ、他の部分は他のクラウド プラットフォームにデプロイされます。各クラウド プラットフォームのトポロジは、ゾーン、リージョン、マルチリージョン、グローバルのデプロイ アーキタイプを使用できます。

| ユースケース |

|

|---|---|

| 設計上の考慮事項 |

|

| 詳細 | 次のセクションをご覧ください。 |

地理的ゾーンとリージョンを選択する

Google Cloud アーキテクチャ フレームワークのこのドキュメントでは、地理的要件に基づいてシステムをデプロイするためのベスト プラクティスについて説明します。ここでは、可用性のサポートと近接性に基づいて最適な地理的ゾーンとリージョンを選択して、コンプライアンスをサポートし、費用の最適化とロード バランシングの実装を行う方法を学習します。

ビジネス アプリケーションに 1 つまたは複数のリージョンを選択する場合は、サービスの可用性、エンドユーザーのレイテンシ、アプリケーションのレイテンシ、コスト、規制またはサステナビリティ要件などの基準を考慮します。ビジネスの優先順位とポリシーをサポートするには、これらの要件のバランスを取り、最適なトレードオフを特定します。たとえば、最も規制を遵守しているリージョンが最も費用対効果の高いリージョンとは限りません。また、二酸化炭素排出量が最も少ないリージョンでない可能性もあります。

複数のリージョンにデプロイする

リージョンは、複数のゾーンから構成された地理的に独立したエリアです。ゾーンは、リージョン内にある Google Cloud リソースのデプロイエリアです。各ゾーンは、リージョン内の単一障害発生ドメインとなります。

予想されるダウンタイム(メンテナンスを含む)から保護し、インシデントなどの予期しないダウンタイムから保護するには、高可用性を備えたフォールト トレラントなアプリケーションをデプロイし、1 つ以上のリージョンの複数のゾーンにアプリケーションをデプロイすることをおすすめします。詳細については、地域とリージョン、アプリケーションのデプロイに関する考慮事項、Compute Engine リージョンの選択に関するベスト プラクティスをご覧ください。

費用やその他の考慮事項が原因でマルチリージョン デプロイが制限されている場合、マルチゾーン デプロイにより復元力を実現できます。このアプローチは、ゾーンまたはリージョンの停止を防ぎ、障害復旧とビジネスの継続性の問題に対処する際に特に役立ちます。詳細については、スケールと高可用性のための設計をご覧ください。

地理的な近接性に基づいてリージョンを選択する

レイテンシはユーザー エクスペリエンスに影響を与えるだけでなく、外部ユーザーへのサービス提供に関連するコストにも影響します。外部ユーザーにトラフィックを提供する際のレイテンシを最小限に抑えるには、ユーザーと地理的に近いリージョンまたはリージョン セットを選択し、サービスがコンプライアンスを遵守した方法で実行されるようにします。詳細については、Cloud のロケーションとコンプライアンス リソース センターをご覧ください。

利用可能なサービスに基づいてリージョンを選択する

ビジネスで使用可能なサービスに基づいてリージョンを選択します。ほとんどのサービスはすべてのリージョンで利用できます。一部のエンタープライズ向けサービスでは、最初のリリースがリージョンのサブセットに限定されている場合があります。リージョンの選択を確認するには、クラウドのロケーションをご覧ください。

コンプライアンスをサポートするリージョンを選択する

一般データ保護規則(GDPR)やデータ所在地など、特定のリージョンの使用を必要とする地理的規制またはコンプライアンスの規制を満たすため、特定のリージョンまたはリージョン セットを選択します。安全なシステムの設計の詳細については、コンプライアンス サービスと Google Cloud の欧州のお客様向けのデータ所在地、運用の透明性、プライバシーをご覧ください。

主要なリソースの料金を比較する

同じサービスでもリージョンによって料金が異なります。費用対効果の高いリージョンを特定するには、使用する予定の主要なリソースの料金を比較します。コストに関する考慮事項は、バックアップの要件や、コンピューティング、ネットワーキング、データ ストレージなどのリソースによって異なります。詳細については、コスト最適化のカテゴリをご覧ください。

Cloud Load Balancing を使用してグローバル ユーザーにサービスを提供する

グローバルなユーザーにサービスを提供する際のユーザー エクスペリエンスを向上させるには、Cloud Load Balancing を使用して、アプリケーションにルーティングされる単一の IP アドレスを提供します。信頼性の高いシステムの設計の詳細については、Google Cloud アーキテクチャ フレームワーク: 信頼性をご覧ください。

サステナビリティをサポートする Cloud Region Picker を使用する

Google は 2007 年からカーボン ニュートラルを達成し、2030 年までにカーボンフリーを目指しています。二酸化炭素排出量に基づいてリージョンを選択するには、Google Cloud リージョン選択ツールを使用します。サステナビリティに向けた設計について詳しくは、クラウドのサステナビリティをご覧ください。

次のステップ

Google Cloud のリソース階層である Resource Manager と組織のポリシー サービスを使用してクラウド リソースを管理する方法を確認する。

アーキテクチャ フレームワークの他のカテゴリ(信頼性、オペレーショナル エクセレンス、セキュリティ、プライバシー、コンプライアンスなど)を確認する。

クラウド リソースを管理する

Google Cloud アーキテクチャ フレームワークのこのドキュメントでは、Google Cloud でリソースを整理および管理するためのベスト プラクティスについて説明します。

リソース階層

Google Cloud のリソースは、組織、フォルダ、プロジェクトに階層的に配置されています。このような階層を使用することで、アクセス制御、構成設定、ポリシーなどリソースに共通する要素を簡単に管理できます。クラウド リソースの階層を設計するためのベスト プラクティスについては、Google Cloud ランディング ゾーンのリソース階層を決定するをご覧ください。

リソースラベルとタグ

このセクションでは、ラベルとタグを使用して Google Cloud リソースを整理するためのベスト プラクティスについて説明します。

シンプルなフォルダ構造を使用する

フォルダを使用すると、プロジェクトとサブフォルダを任意に組み合わせることができます。Google Cloud リソースを整理するシンプルなフォルダ構造を作成します。必要に応じてレベルを追加して、ビジネスニーズをサポートできます。フォルダ構造は柔軟で拡張可能です。詳細については、フォルダの作成と管理をご覧ください。

フォルダとプロジェクトを使用してデータ ガバナンス ポリシーを反映させる

組織内のデータ ガバナンス ポリシーを反映するように、フォルダ、サブフォルダ、プロジェクトを使用してリソースを分離できます。たとえば、フォルダとプロジェクトの組み合わせを使用して、財務、人事、エンジニアリングを分離できます。

プロジェクトを使用して、同じ信頼境界を共有するリソースをグループ化してください。たとえば、同じプロダクトやマイクロサービスのリソースは、同じプロジェクトに含めることができます。詳細については、Google Cloud ランディング ゾーンのリソース階層を決定するをご覧ください。

プロジェクトの開始時にタグとラベルを使用する

Google Cloud プロダクトを初めて使うときにラベルとタグを使用できます(必ずしもすぐに使う必要はありません)。後でラベルとタグを追加する作業は手作業で行う必要があり、エラーが発生しやすくなります。

タグを使用すると、リソースに特定のタグが付加されているかどうかに基づいて、条件付きでポリシーの許可や拒否を行えます。ラベルとは、Google Cloud のインスタンスを整理する際に役立つ Key-Value ペアです。ラベルの詳細については、ラベルの要件、ラベルをサポートするサービスのリスト、ラベルの形式をご覧ください。

Resource Manager が提供するラベルとタグは、リソースの管理やコストの割り当てとレポートに役立ちます。また、きめ細かいアクセス制御を行うために、異なるリソースにポリシーを割り当てる際にも役立ちます。たとえば、ラベルとタグを使用して、さまざまなテナント リソースとサービスにきめ細かいアクセス権と管理の原則を適用できます。VM ラベルとネットワーク タグの詳細については、VM ラベルとネットワーク タグの関係をご覧ください。

ラベルは、次のようなさまざまな用途に使用できます。

- リソースに対する課金の管理: 課金システムでラベルを使用して、コストをラベル別に分割できます。たとえば、異なるコストセンターや予算にラベルを付けることができます。

- 類似した特性または関係に基づいたリソースのグループ化: ラベルを使用して、アプリケーション ライフサイクルのさまざまなステージや環境を分離できます。たとえば、本番環境、開発環境、テスト環境にラベルを付けることができます。

ラベルを割り当てて費用と請求のレポートをサポートする

統合レポート構造(プロジェクトごと、プロダクトごとなど)以外の属性に基づいて、詳細な費用と課金レポートをサポートするには、リソースにラベルを割り当てます。ラベルは、コストセンター、部門、特定のプロジェクトへの費用の割り当てや内部的な費用の振り替えに役立ちます。詳細については、費用最適化のカテゴリをご覧ください。

大量のラベルを作成しない

大量のラベルを作成しないでください。プロジェクト レベルでラベルを作成することをおすすめします。また、サブチームレベルではラベルを作成しないでください。必要以上に詳細なラベルを作成すると、分析にノイズが入る可能性があります。ラベルの一般的なユースケースについては、ラベルの一般的な使用例をご覧ください。

ラベルに機密情報を追加しない

ラベルは、機密情報を処理するように設計されていません。個人名や役職など、個人を特定できる情報もラベルには含めないでください。

プロジェクト名で情報を匿名化する

プロジェクト名は COMPANY_INITIAL_IDENTIFIER-ENVIRONMENT-APP_NAME のようにしてください。ここで、プレースホルダは一意なものとし、会社名やアプリケーション名は公表しないでください。チーム名やテクノロジーなど、将来変更される可能性がある属性は含めないでください。

タグを適用してビジネス ディメンションをモデル化する

タグを適用すると、組織構造、リージョン、ワークロードの種類、コストセンターなど、追加のビジネス ディメンションをモデル化できます。タグの詳細については、タグの概要、タグの継承、タグの作成と管理をご覧ください。タグをポリシーで使用する方法については、ポリシーとタグをご覧ください。タグを使用してアクセス制御を管理する方法については、タグとアクセス制御をご覧ください。

組織のポリシー

このセクションでは、クラウド リソース階層全体にわたる Google Cloud リソースにガバナンス ルールを構成するためのベスト プラクティスについて説明します。

プロジェクトの命名規則を確立する

SYSTEM_NAME-ENVIRONMENT(dev、test、uat、stage、prod)のように、標準化されたプロジェクト命名規則を設定します。

プロジェクト名の長さは 30 文字に制限されています。

COMPANY_TAG-SUB_GROUP/SUBSIDIARY_TAG のような接頭辞を適用できますが、企業の再編があると、プロジェクト名が過去のものになる場合があります。プロジェクト名から識別可能な名前をプロジェクト ラベルに移すことを検討してください。

プロジェクトの作成を自動化する

本番環境や大規模な企業向けのプロジェクトを作成するには、Deployment Manager や Google Cloud プロジェクト ファクトリ Terraform モジュールのような自動プロセスを使用します。これらのツールは、次の処理を行います。

- 開発環境、テスト環境、本番環境を作成し、適切な権限のあるプロジェクトを自動的に作成します。

- ロギングとモニタリングを構成する

Google Cloud プロジェクト ファクトリ Terraform モジュールは、Google Cloud プロジェクトの作成を自動化する際に役立ちます。大企業では、Google Cloud でプロジェクトを作成する前に、プロジェクトを確認して承認することをおすすめします。このプロセスにより、次のことを保証できます。

- 費用を関連付ける。詳細については、費用最適化のカテゴリをご覧ください。

- データ アップロードの承認を行う。

- 規制やコンプライアンスの要件を満たす。

Google Cloud プロジェクトとリソースの作成や管理を自動化すると、整合性、再現性、テスト容易性の面でメリットを得られます。コードとして構成を扱うことで、ソフトウェア アーティファクトと一緒にバージョニングして、構成のライフサイクルを管理できます。自動化により、リソースに一貫した命名規則やラベル付けを行うなど、ベスト プラクティスに対応できます。自動化により、要件の変化に合わせて、プロジェクトのリファクタリングを容易に行うことができます。

システムを定期的に監査する

新しいプロジェクトに対するリクエストが監査、承認されるようにするには、企業のチケット システムや監査を提供するスタンドアロン システムを統合します。

一貫性を保ってプロジェクトを構成する

プロジェクトは、組織のニーズが一貫して満たされるように構成します。プロジェクトを設定するときは、次のものを含めます。

- プロジェクト ID と命名規則

- 請求先アカウントのリンク

- ネットワーク構成

- 有効な API とサービス

- Compute Engine のアクセス構成

- ログのエクスポートと使用状況レポート

- プロジェクト削除リーエン

ワークロードや環境を切り離す

割り当てと上限は、プロジェクト レベルで適用されます。割り当てと上限を管理するには、ワークロードや環境をプロジェクト レベルで切り離します。詳細については、割り当ての操作をご覧ください。

環境の分離は、データ分類の要件とは異なります。データをインフラストラクチャから分けることは、実装が高コストで複雑になるため、データの機密性とコンプライアンス要件に基づいてデータの分類を実装することをおすすめします。

課金の分離を適用する

課金の分離を適用して、異なる請求先アカウントに対応し、ワークロードや環境ごとの費用の可視性をサポートします。詳細については、セルフサービス Cloud 請求先アカウントの作成、変更、閉鎖とプロジェクトの課金の有効化、無効化、変更をご覧ください。

管理の複雑さを最小限に抑えるため、プロジェクト レベルの重要な環境や、複数のプロジェクトにまたがるワークロードに対して、詳細なアクセス管理を行います。重要な本番環境のアプリケーションにアクセス制御を作成すると、ワークロードを保護して安全に管理できます。

組織のポリシー サービスを使用してリソースを制御する

組織ポリシー サービスでは、ポリシー管理者に組織のクラウド リソースの一元管理と、プログラムによる制御権が与えられます。これにより、リソース階層全体にわたる制約を構成できます。詳細については、組織のポリシー管理者の追加をご覧ください。

組織のポリシーを使用して規制ポリシーを遵守する

コンプライアンス要件を満たすには、組織ポリシー サービスを使用して、リソースの共有とアクセスにコンプライアンス要件を適用します。たとえば、外部関係者との共有を制限したり、クラウド リソースを地理的にデプロイする場所を決定します。その他のコンプライアンス シナリオとしては次のものがあります。

- 制御の集中化により、組織のリソースの使用方法を定義する制限を構成する。

- 開発チームがコンプライアンスを遵守できるようにポリシーを定義して確立する。

- 規制遵守を維持し、さらにコンプライアンス ルール違反の懸念を最小限に抑えながら、プロジェクト オーナーとチームがシステムを変更できるように支援する。

ドメインに基づいてリソースの共有を制限する

共有に関する制限された組織のポリシーを使用すると、Google Cloud リソースが組織外の ID と共有されるのを防ぐことができます。詳細については、ドメイン別の ID の制限と、組織のポリシーの制約をご覧ください。

サービス アカウントとキーの作成を無効にする

セキュリティを強化するには、Identity and Access Management(IAM)のサービス アカウントと対応するキーの使用を制限します。詳細については、サービス アカウントの使用を制限するをご覧ください。

新しいリソースの物理的な場所を制限する

リソース ロケーションを制限して、新しく作成されたリソースの物理的なロケーションを制限します。組織のリソースを制御するための制約のリストについては、組織のポリシーのサービスの制約をご覧ください。

次のステップ

コンピューティングを選択して管理する方法を確認する。次のものを確認します。

アーキテクチャ フレームワークの他のカテゴリ(信頼性、オペレーショナル エクセレンス、セキュリティ、プライバシー、コンプライアンスなど)を確認する。

コンピューティングを選択して管理する

Google Cloud アーキテクチャ フレームワークのこのドキュメントでは、コンピューティング要件に基づいてシステムをデプロイするためのベスト プラクティスについて説明します。コンピューティング プラットフォームと移行方法の選択、ワークロードの設計とスケーリング、オペレーションと VM 移行の管理を行う方法について説明します。

カスタム ビジネス ロジックの実行や、データセットに対する複雑な計算アルゴリズムの適用など、コンピューティングは多くのワークロードの中核となります。ほとんどのソリューションではなんらかの形でコンピューティング リソースが使用されます。そのため、アプリケーションのニーズに合ったコンピューティング リソースを選択することが重要です。

Google Cloud には、CPU 時間を使用するためのオプションがいくつか用意されています。オプションは、CPU タイプ、パフォーマンス、コードの実行スケジュール(使用量に対する課金を含む)に基づきます。

Google Cloud には、次のコンピューティング オプションが用意されています。

- ライブ マイグレーションなどのクラウド固有のメリットがある仮想マシン(VM)。

- CPU を共有可能なクラスタマシン上のコンテナのビンパッキング。

- 関数とサーバーレス アプローチ。CPU 時間は、単一の HTTP リクエスト中に実行される作業で測定できます。

コンピューティングを選択する

このセクションでは、コンピューティング プラットフォームを選択して移行する際のベスト プラクティスについて説明します。

コンピューティング プラットフォームを選択する

ワークロードにコンピューティング プラットフォームを選択する際は、ワークロードの技術要件、ライフサイクル自動化プロセス、リージョン指定、セキュリティを考慮してください。

アプリとサポート システム全体による CPU 使用状況を評価します。たとえば、コードをパッケージ化してデプロイ、分散、呼び出す方法を評価します。複数のプラットフォーム オプションとの互換性があるシナリオもありますが、ポータブル ワークロードは、さまざまなコンピューティング オプションに対応し、高いパフォーマンスを実現する必要があります。

次の表に、さまざまなユースケースで推奨される Google Cloud コンピューティング サービスの概要を示します。

| コンピューティング プラットフォーム | ユースケース | 推奨プロダクト |

|---|---|---|

| サーバーレス |

|

|

| Kubernetes | サービス メッシュ コントロールを管理するために Istio などの追加サービスを必要とする複雑なマイクロサービス アーキテクチャを構築します。 |

|

| 仮想マシン(VM) | アプリケーションやワークロードの要件を満たすだけでなく、サードパーティのソフトウェアとサービスにも対応している、カスタマイズ可能な事前定義の VM ファミリーから VM を作成して実行します。 |

要件に基づいて適切なマシンタイプを選択するには、マシン ファミリーに関する推奨事項をご覧ください。 |

詳細については、コンピューティング オプションの選択をご覧ください。

コンピューティングの移行アプローチを選択する

既存のアプリケーションを別のクラウドまたはオンプレミスから移行する場合は、次のいずれかの Google Cloud プロダクトを使用して、パフォーマンス、スケール、コスト、セキュリティを最適化します。

| 移行目標 | ユースケース | 推奨プロダクト |

|---|---|---|

| リフト&シフト | VMware ワークロードを数分で Google Cloud に移行または拡張できます。 | Google Cloud VMware Engine |

| リフト&シフト | VM ベースのアプリケーションを Compute Engine に移行します。 | Migrate to Virtual Machines |

| コンテナへのアップグレード | 従来のアプリケーションを Google Kubernetes Engine の組み込みコンテナにモダナイズします。 | Migrate to Containers |

内部チームを連携させながらワークロードを移行する方法については、VM Migration のライフサイクルと Google Cloud を使用した大規模な移行プログラムの構築をご覧ください。

ワークロードの設計

このセクションでは、システムをサポートするワークロードを設計する際のベスト プラクティスについて説明します。

シンプルなロジックのサーバーレス オプションを評価する

シンプルなロジックは、特別なハードウェアや CPU 最適化マシンなどのマシンタイプを必要としないコンピューティング タイプです。Google Kubernetes Engine(GKE)または Compute Engine の実装に投資して運用上のオーバーヘッドを抽象化し、コストとパフォーマンスを最適化する前に、軽量ロジック用のサーバーレス オプションを評価してください。

アプリケーションを分離してステートレスにする

可能であれば、アプリケーションを分離してステートレスにすることで、サーバーレス コンピューティング オプションを最大限に活用できます。このアプローチでは、マネージド コンピューティング サービスを使用して、需要に応じてアプリケーションをスケーリングするので、費用とパフォーマンスを最適化できます。アプリケーションを切り離してスケーリングと高可用性を実現するように設計する詳しい方法については、スケーリングと高可用性を設計するをご覧ください。

アーキテクチャの分離にキャッシュ ロジックを使用する

アプリケーションがステートフルに設計されている場合は、キャッシュ ロジックを使用して分離し、ワークロードをスケーラブルにします。詳しくは、データベースに関するベスト プラクティスをご覧ください。

ライブ マイグレーションを使用してアップグレードを促進する

Google のメンテナンス アップグレードを容易にするために、インスタンスの可用性ポリシーを設定してライブ マイグレーションを使用します。詳細については、VM ホスト メンテナンス ポリシーの設定をご覧ください。

ワークロードのスケーリング

このセクションでは、システムをサポートするためにワークロードをスケーリングする際のベスト プラクティスについて説明します。

起動スクリプトとシャットダウン スクリプトを使用する

ステートフル アプリケーションの場合は、可能であれば起動スクリプトとシャットダウン スクリプトを使用して、アプリケーションの起動と停止を正常に行います。正常な起動とは、コンピュータがソフトウェアによって起動され、オペレーティング システムがプロセスを安全に開始して接続を開始できる状態を意味します。

ステートフル アプリケーションは、コンピューティング リソース(ローカルディスク、永続ディスク、RAM など)の近くにあるデータをいつでも利用できる状態にしておく必要があるため、正常な起動とシャットダウンは重要です。起動のたびにアプリケーション データを最初から読み込まないようにするには、起動スクリプトを使用して、最後に保存したデータを再度読み込みし、シャットダウン時に前回停止した場所からプロセスを実行します。シャットダウン時に進行状況が失われるのを回避するため、シャットダウン スクリプトを使用して、アプリケーションのメモリの状態を保存します。たとえば、ダウンスケーリングや Google のメンテナンス イベントにより VM がシャットダウンされる予定がある場合に、シャットダウン スクリプトを使用します。

MIG を使用して VM 管理をサポートする

Compute Engine VM を使用する場合、マネージド インスタンス グループ(MIG)は、自動修復、ロード バランシング、自動スケーリング、自動更新、ステートフル ワークロードなどの機能をサポートしています。可用性の目標に基づいて、ゾーン MIG またはリージョン MIG を作成できます。MIG は、ステートレス サービスやバッチ ワークロードのほか、各 VM に固有の状態を保持する必要があるステートフル アプリケーションに使用できます。

Pod オートスケーラーを使用して GKE ワークロードをスケーリングする

水平および垂直 Pod オートスケーラーを使用してワークロードをスケールし、ノードの自動プロビジョニングを使用して基盤となるコンピューティング リソースをスケールします。

アプリケーション トラフィックを分散する

アプリケーションをグローバルにスケーリングするには、Cloud Load Balancing を使用してアプリケーション インスタンスを複数のリージョンまたはゾーンに分散します。ロードバランサは、Google Cloud エッジ ネットワークから最も近いゾーンへのパケット ルーティングを最適化することで、トラフィックの処理効率を高め、コストを最小限に抑えます。エンドユーザーのレイテンシを最適化するには、Cloud CDN を使用して、静的コンテンツを可能な限りキャッシュに保存します。

コンピューティングの作成と管理を自動化する

コンピューティングの作成と管理を自動化することで、本番環境で人為的エラーを最小限に抑えます。

運用の管理

このセクションでは、システムをサポートするための運用管理のベスト プラクティスについて説明します。

Google 提供の公開イメージを使用する

Google Cloud が提供する公開イメージを使用します。Google Cloud の公開イメージは定期的に更新されます。詳細については、Compute Engine で利用可能な公開イメージのリストをご覧ください。

特定の構成と設定で独自のイメージを作成することもできます。可能であれば、組織内の承認済みユーザーと共有できる別のプロジェクトでイメージの作成を自動化し、一元化します。別のプロジェクトでカスタム イメージを作成してキュレートすると、独自の構成で VM の更新、パッチ適用、作成を行うことができます。その後、キュレートされた VM イメージを関連プロジェクトと共有できます。

インスタンスのバックアップにスナップショットを使用する

スナップショットを使用すると、インスタンスのバックアップを作成できます。スナップショットは、予期しないシャットダウンが発生したときに状態の維持や進行状況の保存ができない、柔軟性のないステートフル アプリケーションに特に有効です。スナップショットを頻繁に使用して新しいインスタンスを作成する場合は、そのスナップショットからベースイメージを作成することでバックアップ プロセスを最適化できます。

マシンイメージを使用して VM インスタンスの作成を有効にする

スナップショットはマシン内のデータのイメージのみをキャプチャしますが、マシンイメージはデータに加えてマシンの構成と設定をキャプチャします。マシンイメージを使用すると、VM インスタンスを作成するために必要な構成、メタデータ、権限、1 つ以上のディスクのデータをすべて保存できます。

スナップショットからマシンを作成する場合、新しい VM インスタンスでインスタンスを構成する必要がありますが、これには多くの作業が必要です。マシンイメージを使用すると、既知の設定を新しいマシンにコピーするので、オーバーヘッドを削減できます。詳細については、マシンイメージを使用する状況をご覧ください。

容量、予約、分離

このセクションでは、システムをサポートするために容量、予約、分離を管理するためのベスト プラクティスについて説明します。

確約利用割引を使用して費用を削減する

確約利用割引を使用することで、常時稼働しているワークロードの運用コスト(OPEX)を低減できます。詳細については、費用最適化のカテゴリをご覧ください。

費用とパフォーマンスをサポートするマシンタイプを選択する

Google Cloud では、費用とパフォーマンスのパラメータに基づいてコンピューティングを選択できるマシンタイプが用意されています。低パフォーマンスのプロダクトを選択してコストを最適化することも、高コストで高パフォーマンスのコンピューティング オプションを使用することもできます。詳細については、費用最適化のカテゴリをご覧ください。

単一テナントノードを使用してコンプライアンスのニーズに対応する

単一テナントノードは、プロジェクトの VM のみをホストする専用の物理的な Compute Engine サーバーです。単一テナントノードは、次のような物理的な分離のコンプライアンス要件を満たすのに役立ちます。

- VM を他のプロジェクトの VM から物理的に分離する。

- 同じホスト ハードウェア上の VM をグループ化する。

- 支払い処理のワークロードを分離する。

詳細については、単一テナントノードをご覧ください。

予約を使用してリソースの可用性を確保する

Google Cloud では、ワークロードの予約を定義して、これらのリソースを常に使用できます。予約の作成には追加料金は発生しませんが、予約したリソースを使用しない場合でも、予約されたリソースに対して料金が発生します。詳細については、予約の使用と管理をご覧ください。

VM の移行

このセクションでは、システムをサポートするために VM を移行する際のベスト プラクティスについて説明します。

組み込みの移行ツールを評価する

組み込みの移行ツールを使用して、ワークロードを別のクラウドまたはオンプレミスから移行します。詳細については、Google Cloud への移行をご覧ください。Google Cloud には、ワークロードの移行と費用とパフォーマンスの最適化に役立つツールやサービスが用意されています。現在の IT 環境に基づく移行コストを無料で評価するには、Google Cloud 高速評価および移行プログラムをご覧ください。

仮想オペレーティング システムの OS をカスタマイズする

カスタマイズされたサポート対象のオペレーティング システムをインポートするには、仮想ディスクのインポートをご覧ください。単一テナントノードでは、コアごとまたはプロセッサごとのライセンスで、ハードウェアに対するお客様所有のライセンスの使用要件を満たすことができます。詳細については、お客様所有のライセンスの使用をご覧ください。

推奨事項

アーキテクチャ フレームワークのガイダンスを独自の環境に適用するには、次のことをおすすめします。

Google Cloud Marketplace サービスを確認して、サポートされているベンダーのリストにアプリケーションが含まれているかどうか確認します。Google Cloud は、さまざまなオープンソース システムとサードパーティ ソフトウェアの実行をサポートしています。

VM ベースのアプリケーションを GKE で実行しているコンテナ化アプリケーションとして抽出してパッケージ化するには、Migrate to Containers と GKE を検討してください。

Compute Engine を使用して、Google Cloud でアプリケーションを実行します。VM ベースのアプリケーションで以前の依存関係を実行している場合は、ベンダーの要件を満たしているかどうかを確認します。

Google Cloud の内部パススルー ネットワーク ロードバランサを使用して評価し、分離されたアーキテクチャをスケーリングします。詳細については、内部パススルー ネットワーク ロードバランサの概要をご覧ください。

従来のオンプレミス ユースケース(HA Proxy の使用など)から移行するオプションを評価します。詳細については、フローティング IP アドレスのベスト プラクティスをご覧ください。

VM Manager を使用して、Compute Engine 上で Windows と Linux を実行する大規模な VM フリート用のオペレーティング システムを管理し、一貫性のある構成ポリシーを適用します。

GKE Autopilot を使用して、Google SRE でクラスタを完全に管理できるようにすることを検討してください。

GKE クラスタ全体のポリシーと構成の管理には、Policy Controller と Config Sync を使用します。

特定のリージョンとゾーンのマシンの可用性とスケーラビリティを確保します。Google Cloud では、コンピューティング ニーズに応じたスケーリングが可能です。ただし、特定のリージョンやゾーンで特定のマシンタイプを増やす必要がある場合は、アカウント チームと協力して可用性を確保してください。詳細については、Compute Engine の予約をご覧ください。

次のステップ

次のようなネットワーク設計の原則について学習する。

ワークロード VPC アーキテクチャを設計する。

VPC 間の接続を設計する。

アーキテクチャ フレームワークの他のカテゴリ(信頼性、オペレーショナル エクセレンス、セキュリティ、プライバシー、コンプライアンスなど)を確認する。

ネットワーク インフラストラクチャを設計する

Google Cloud アーキテクチャ フレームワークのこのドキュメントでは、ネットワーク設計に基づいてシステムをデプロイするためのベスト プラクティスを説明します。Virtual Private Cloud(VPC)の選択と実装の方法、ネットワーク セキュリティのテストと管理の方法を説明します。

基本原則

ネットワーク設計は、パフォーマンスを最適化し、内部サービスと外部サービスとのアプリケーション通信を保護するうえで役立つことから、システム設計を成功させるために不可欠です。ネットワーク サービスを選択する際は、アプリケーションのニーズを評価し、アプリケーション間の通信方法を評価することが重要です。たとえば、一部のコンポーネントではグローバル サービスが必要ですが、他のコンポーネントは特定のリージョンで位置情報を設定しておく必要があります。

Google のプライベート ネットワークでは、リージョンのロケーションが 100 を超えるグローバル ネットワーク拠点に接続されています。Google Cloud は、ソフトウェア定義ネットワーキングと分散システム テクノロジーにより、世界中でサービスをホストし、配信しています。Google Cloud 内のネットワーキングに関する Google のコア要素は、グローバル VPC です。VPC は、Google のグローバル高速ネットワークを使用して、プライバシーと信頼性をサポートしながら、リージョンをまたいでアプリケーションをリンクします。Google では、ボトルネック帯域幅およびラウンドトリップ伝搬時間(BBR)の輻輳制御インテリジェンスなどのテクノロジーを使用して、高スループットでコンテンツを配信します。

クラウド ネットワーキングの設計では、次のステップを行います。

- ワークロードの VPC アーキテクチャを設計する。先にどれだけの Google Cloud プロジェクトと VPC ネットワークが必要かを特定する。

- VPC 間の接続を追加する。ワークロードを異なる VPC ネットワーク上の他のワークロードと接続する方法を設計する。

- ハイブリッド ネットワークの接続を設計する。ワークロードの VPC をオンプレミスおよび他のクラウド環境に接続する方法を設計する。

Google Cloud ネットワークを設計するときは、以下を考慮します。

- VPC には、Compute Engine、Google Kubernetes Engine(GKE)、サーバーレス コンピューティング ソリューション 上で構築されたサービスの相互接続を実現するためのクラウド内のプライベート ネットワーク環境が用意されています。VPC を使用して、Cloud Storage、BigQuery、Cloud SQL などの Google マネージド サービスにプライベートでアクセスすることもできます。

- VPC ネットワーク(その関連ルートやファイアウォール ルールを含む)はグローバル リソースです。特定のリージョンやゾーンには関連付けられていません。

- サブネットはリージョン リソースです。同じクラウド リージョン内の異なるゾーンにデプロイされた Compute Engine VM インスタンスは、同じサブネットの IP アドレスを使用できます。

- インスタンス間のトラフィックは、VPC ファイアウォール ルールを使用して制御できます。

- ネットワーク管理は、Identity and Access Management(IAM)のロールを使用して保護できます。

- ハイブリッド環境の VPC ネットワークは、Cloud VPN または Cloud Interconnect を使用して安全に接続できます。

VPC 仕様の完全なリストについては、仕様をご覧ください。

ワークロードの VPC アーキテクチャ

このセクションでは、システムをサポートするワークロード VPC アーキテクチャを設計する際のベスト プラクティスについて説明します。

VPC ネットワーク設計を早期に検討する

Google Cloud での組織の設定を設計する初期段階で VPC ネットワーク設計を行います。組織レベルでの設計の選択内容は、後で簡単には元に戻せません。詳細については、VPC 設計のためのおすすめの方法とリファレンス アーキテクチャと Google Cloud ランディング ゾーンのネットワーク設計を決定するをご覧ください。

単一の VPC ネットワークで開始する

要件が共通するリソースが含まれる多くのユースケースでは、単一 VPC ネットワークによって必要な機能が提供されます。単一 VPC ネットワークは、簡単に作成、維持管理、理解できます。詳細については、VPC ネットワークの仕様をご覧ください。

VPC ネットワーク トポロジをシンプルに保つ

管理しやすく、信頼性が高く、十分に理解されるアーキテクチャを実現するには、VPC ネットワーク トポロジの設計を可能な限り簡素化します。

VPC ネットワークをカスタムモードで使用する

Google Cloud ネットワーキングが既存ネットワーキング システムとシームレスに統合されるよう、VPC ネットワーク作成時にはカスタムモードを使用することをおすすめします。カスタムモードを使用することで、Google Cloud ネットワーキングを既存の IP アドレス管理スキームに統合し、どのクラウド リージョンを VPC に含めるかを管理できるようになります。詳細については、VPC をご覧ください。

VPC 間の接続

このセクションでは、システムをサポートする VPC 間の接続を設計する際のベスト プラクティスについて説明します。

VPC 接続方法を選択する

複数の VPC ネットワークを導入する場合は、これらのネットワークを連結する必要があります。VPC ネットワークは、Google の Andromeda ソフトウェア定義ネットワーク(SDN)内の独立したテナント スペースです。VPC ネットワークは、複数の方法で互いに通信できます。帯域幅、レイテンシ、サービスレベル契約(SLA)の要件に従い、ネットワークをどのように接続するかを選択してください。接続オプションの詳細については、コスト、パフォーマンス、セキュリティのニーズを満たす VPC 接続方式を選択するをご覧ください。

共有 VPC を使用して、複数のワーキング グループを管理する

組織内に複数のチームがある場合、共有 VPC は、単一 VPC ネットワークのシンプルなアーキテクチャを複数の作業グループに拡張するための効果的なツールになります。

わかりやすい命名規則を採用する

直感的にわかりやすく、一貫性のある命名規則を選択してください。これにより、管理者とユーザーが各リソースの目的、各リソースの配置、各リソースが他のリソースとどのように区別されるかを理解しやすくなります。

接続テストを行って、ネットワーク セキュリティを検証する

ネットワーク セキュリティを確保するため、接続テストを実施することで、2 つのエンドポイント間で遮断したいトラフィックが遮断できているかを検証できます。トラフィックが遮断されているか、なぜ遮断されているかを確認するために、2 つのエンドポイント間での試験を定義し、結果を評価してください。たとえば、トラフィックのブロックをサポートするルールを定義できるようにする VPC 機能をテストできます。詳細については、接続テストの概要をご覧ください。

Private Service Connect を使用して、プライベート エンドポイントを作成する

自社の IP アドレス スキームを使用して Google サービスにアクセスするプライベート エンドポイントを作成するには、Private Service Connect を使用します。VPC 内から、VPC に終端されたハイブリッド接続を介してプライベート エンドポイントにアクセスできます。

外部接続の保護と制限を行う

インターネットへのアクセスは、このアクセスを必要とするリソースのみに許可します。限定公開の Google アクセスを使用すると、プライベートの内部 IP アドレスしかないリソースでも多くの Google API やサービスにアクセスできます。

Network Intelligence Center を使用してクラウド ネットワークをモニタリングする

Network Intelligence Center では、すべてのリージョンにわたる Google Cloud ネットワークの包括的なビューを利用できます。運用上のリスクやセキュリティ リスクを引き起こす可能性があるトラフィック パターンとアクセス パターンを特定するのに役立ちます。

次のステップ

以下を含む、ストレージ管理に関するベスト プラクティスについて確認する。

アーキテクチャ フレームワークの他のカテゴリ(信頼性、オペレーショナル エクセレンス、セキュリティ、プライバシー、コンプライアンスなど)を確認する。

ストレージ戦略を選択して実装する

Google Cloud アーキテクチャ フレームワークのこのドキュメントでは、ストレージに基づいてシステムをデプロイするためのベスト プラクティスについて説明します。ストレージ戦略を選択する方法と、ストレージ、アクセス パターン、ワークロードを管理する方法について取り上げます。

データ交換を促進し、データのバックアップと保存を安全に行うには、ワークロード、1 秒あたりの入出力オペレーション(IOPS)、レイテンシ、取得頻度、場所、容量、形式(ブロック、ファイル、オブジェクト)に基づいてストレージ プランを選択する必要があります。

Cloud Storage は、次のような信頼性の高い安全なオブジェクト ストレージ サービスを提供します。

- 組み込みの冗長性オプションによって機器の故障からデータが保護され、データセンターのメンテナンス中でもデータの可用性を確保。

- 次のようなデータ転送オプション:

- ワークロードをサポートするストレージ クラス。

- Google が読み取りと書き込みを検証できる、すべての Cloud Storage オペレーションに対して計算されたチェックサム。

Google Cloud では、IOPS はプロビジョニングされた保存容量に応じてスケールします。Persistent Disk などのストレージ タイプはゾーン ストレージまたはリージョン ストレージであるため、手動でのレプリケーションとバックアップが必要になります。反対にオブジェクト ストレージは可用性が高く、1 つのリージョンやマルチ リージョン全体で、自動でデータを複製します。

ストレージの種類

このセクションでは、システムをサポートするストレージ タイプを選択するためのベスト プラクティスについて説明します。

高性能ストレージ ニーズのオプションを評価する

高性能ストレージを必要とするコンピューティング アプリケーション向けの永続ディスクもしくはローカル SSD(ソリッド ステート ドライブ)を評価します。Cloud Storage は、バージョニング可能なイミュータブル オブジェクト ストレージ サービスです。Cloud Storage を Cloud CDN とともに使用すると、特に頻繁にアクセスされる静的オブジェクトについてコストを最適化できます。

Filestore は、高性能の共有スペースを必要とするマルチライト アプリケーションをサポートします。Filestore は、ネットワーク ファイル システム(NFS)のマウントを介した POSIX のようなファイル操作を必要とするレガシー アプリケーションと最新のアプリケーションもサポートします。

Cloud Storage は、データレイクの作成やアーカイブ要件への対処などのユースケースをサポートします。特に保持ポリシーを構成する際は、アクセスコストと検索コストによる Cloud Storage クラスの選択に基づいてトレードオフを決定します。詳細については、クラウド ワークロードに最適なストレージ戦略の設計をご覧ください。

どのストレージ オプションでも、デフォルトでは保存時と転送時に Google が管理する鍵を使用してデータが暗号化されます。Persistent Disk や Cloud Storage などのストレージ タイプの場合、独自の鍵を指定することも、Cloud Key Management Service(Cloud KMS)を使用して鍵を管理することもできます。このような鍵を本番環境データで使用する前に、鍵の処理方法を確立してください。

Google Cloud サービスでストレージ デザインをサポートする

ストレージ設計をサポートする Google Cloud サービスについては、次の表をご覧ください。

| Google Cloud サービス | Description |

|---|---|

| Cloud Storage | 世界中のどこからでも、いつでもデータを保存、取得でき、データの量に制限はありません。Cloud Storage は、ウェブサイト コンテンツの配信や、アーカイブおよび障害復旧を目的としたデータの保存、直接ダウンロードによるユーザーへの大規模なデータ オブジェクトの配布など、複数のシナリオで利用できます。 詳しくは以下をご覧ください。 |

| Persistent Disk | Google Cloud 向けの高性能なブロック ストレージPersistent Disk は、Compute Engine または Google Kubernetes Engine で実行されているインスタンスに接続可能な SSD ストレージとハードディスク ドライブ(HDD)ストレージを提供します。

|

| Filestore | データ用のファイル システム インターフェースと共有ファイル システムを必要とするアプリケーション向けのマネージド ファイル ストレージ サービスです。Filestore を使用することにより、Compute Engine や GKE のインスタンスでマネージド ネットワーク接続ストレージ(NAS)をシームレスに活用できるようになります。 |

| Cloud Storage for Firebase | 写真や動画のようなユーザー作成コンテンツを保存し配信する必要のあるアプリ デベロッパー向けに構築されています。すべてのファイルは Cloud Storage バケットに保存されているので、Firebase と Google Cloud の両方からアクセスが可能です。 |

ストレージ戦略を選択する

アプリケーションの要件に合ったストレージ戦略を選択するには、次の表をご覧ください。

| ユースケース | 推奨事項 |

|---|---|

| 最小限のコストで大規模にデータを格納する必要があり、アクセス パフォーマンスが問題にならない。 | Cloud Storage |

| 即時ストレージを必要とするコンピューティング アプリケーションを実行している。 詳細については、Persistent Disk とローカル SSD のパフォーマンスの最適化をご覧ください。 |

Persistent Disk またはローカル SSD |

| 共有スペースに対する読み取りと書き込みのアクセス権が必要な高パフォーマンス ワークロードを実行している。 | Filestore |

| ハイ パフォーマンス コンピューティング(HPC)またはハイ スループット コンピューティング(HTC)のユースケース。 | クラウド上でのクラスタを利用した大規模なテクニカル コンピューティング実行 |

ストレージ アクセスのニーズに基づいてアクティブ ストレージまたはアーカイブ ストレージを選択する

ストレージ クラスは、すべてのオブジェクトで使用されるメタデータです。可用性が高く、高頻度で提供されるデータの場合は、Standard Storage クラスを使用します。アクセス頻度が低く、やや可用性が低くてもよいデータには、Nearline Storage クラス、Coldline Storage クラス、Archive Storage クラスを使用します。ストレージ クラスを選択する際の費用に関する考慮事項については、Cloud Storage の料金をご覧ください。

Cloud Storage についてストレージの場所とデータ保護に関するニーズを評価する

リージョンに配置された Cloud Storage バケットの場合、バケット内に含まれるデータはリージョン内のゾーン間で自動的に複製されます。ゾーン間でのデータ レプリケーションは、リージョン内でゾーン障害が発生した場合にデータを保護します。

Cloud Storage にはリージョン間で冗長なロケーションも用意されています。つまり、データは地理的に離れた複数のデータセンターに複製されます。詳細については、バケットのロケーションをご覧ください。

Cloud CDN を使用して静的オブジェクトの配信を向上させる

オブジェクトの取得コストを最適化し、アクセス レイテンシを最小にするには、Cloud CDN を使用します。Cloud CDN は、Cloud Load Balancing の外部アプリケーション ロードバランサを使用して、ルーティングとヘルスチェックを行い、エニーキャスト IP アドレスをサポートします。詳細については、クラウド バケットを使用して Cloud CDN を設定するをご覧ください。

ストレージ アクセス パターンとワークロード タイプ

このセクションでは、システムをサポートするストレージ アクセス パターンとワークロード タイプを選択する際のベスト プラクティスについて説明します。

Persistent Disk を使用して高性能ストレージへのアクセスをサポートする

データ アクセスパターンは、システム パフォーマンスをどのようにデザインするかによって変わります。Cloud Storage はスケーラブルなストレージを提供しますが、大量のデータに高いスループットでアクセスする必要のある重い計算ワークロードを実行する場合は、理想的な選択ではありません。高性能ストレージ アクセスには、Persistent Disk を使用します。

リトライ ロジックの実装時に指数バックオフを使用する

5XX、408、429 エラーを処理するために、リトライ ロジックの実装時に指数バックオフを使用します。各 Cloud Storage バケットには、初期 I/O キャパシティが設定されています。詳細については、リクエスト レートとアクセス配信のガイドラインをご覧ください。リトライ要求の段階的な立ち上げを計画する。

ストレージ管理

このセクションでは、システムをサポートするためのストレージ管理のベスト プラクティスについて説明します。

すべてのバケットに固有の名前を設定する

すべてのバケット名を Cloud Storage 名前空間内で一意にします。バケット名には機密情報を含めないでください。推測しにくいバケット名とオブジェクト名を選択してください。詳細については、バケットの命名ガイドラインとオブジェクトの命名ガイドラインをご覧ください。

Cloud Storage バケットを非公開の状態に保持する

ビジネス上の理由がない限り、Cloud Storage バケットに匿名アクセスまたは一般アクセスができないようにしてください。詳細については、アクセス制御の概要をご覧ください。

ランダムなオブジェクト名を割り当てて、負荷を均等に分散する

ランダムなオブジェクト名を割り当てて、パフォーマンスを改善し、ホットスポットを回避します。可能であれば、オブジェクトの接頭辞をランダムにします。詳細については、命名規則を使って負荷をキーの範囲に均等に分散するをご覧ください。

公開アクセス防止を使用する

組織、フォルダ、プロジェクト、バケットレベルのアクセスを防止するには、公開アクセスの防止を使用します。詳しくは、公開アクセスの防止の使用をご覧ください。

次のステップ

Google Cloud データベース サービスと、次のようなベスト プラクティスについて確認します。

- データベースを選択して移行する。

- データベースの暗号化を管理する。

- データベースのネットワークとアクセスを管理する。

アーキテクチャ フレームワークの他のカテゴリ(信頼性、オペレーショナル エクセレンス、セキュリティ、プライバシー、コンプライアンスなど)を確認する。

データベースを最適化する

Google Cloud アーキテクチャ フレームワークのこのドキュメントでは、データベース設計に基づいてシステムをデプロイするためのベスト プラクティスを説明します。データベースの設計、移行、スケーリング、データベース情報の暗号化、ライセンスの管理、データベースのイベントのモニタリングを行う方法が学べます。

主なサービス

このアーキテクチャ フレームワークのシステム設計カテゴリのドキュメントでは、さまざまな Google Cloud データベース サービスを含むベスト プラクティスについて説明します。次の表に、これらのサービスの概要を示します。

| Google Cloud サービス | 説明 |

|---|---|

| Cloud SQL | フルマネージド データベース サービス。Cloud SQL for PostgreSQL、Cloud SQL for MySQL、Cloud SQL for SQL Server を使用するリレーショナル データベースを設定、維持、管理できます。Cloud SQL は高いパフォーマンスとスケーラビリティを実現します。Google Cloud 上でホストされる Cloud SQL では、どこでもアプリケーションを実行できるデータベース インフラストラクチャを利用できます。 |

| Bigtable | 数十億行、数千列の規模にスケーリングできるテーブル。最大でペタバイト規模のデータを保存できます。各行の単一の値がインデックスに登録され、この値が行キーとなります。Bigtable を使用すると、非常に低いレイテンシで大量の単一キーデータを保存できます。低レイテンシで高い読み取り / 書き込みスループットを実現できます。また、MapReduce オペレーションのデータソースです。 |

| Spanner | リレーショナル データベース構造と非リレーショナル データベースの水平スケーラビリティを含む、クラウド用に構築されたスケーラブルでグローバルに分散されたエンタープライズ データベース サービス。この組み合わせにより高パフォーマンスのトランザクションと、行、リージョン、大陸をまたぐ整合性が実現します。Spanner により 99.999% の可用性 SLA、計画的ダウンタイムの排除、エンタープライズ クラスのセキュリティが実現します。 |

| Memorystore | Google Cloud 向けのフルマネージド Redis サービス。Google Cloud で実行されるアプリケーションでは、複雑な Redis デプロイを管理することなく、可用性が高くスケーラブルで安全な Redis サービスを使用して、パフォーマンスを向上できます。 |

| Firestore | 自動スケーリングと高性能を実現し、アプリケーション開発のために構築された NoSQL ドキュメント データベース。Firestore のインターフェースは従来のデータベースと同じ機能を多数備えていますが、NoSQL データベースであり、データ オブジェクト間の関係を表現する方法が異なります。 |

| Firebase Realtime Database | クラウドでホストされるデータベース。Firebase ではデータを JSON として保存し、接続されたすべてのクライアントとリアルタイムで同期します。Google、iOS、Android、JavaScript SDK を使用してクロスプラットフォーム アプリを構築した場合、すべてのクライアントが、1 つのリアルタイム データベース インスタンスを共有して、最新のデータによる更新を自動的に受信します。 |

| オープンソース データベース | Google パートナーは、MongoDB、MariaDB、Redis など、さまざまなオープンソース データベースを提供しています。 |

| AlloyDB for PostgreSQL | 要求の厳しいエンタープライズ ワークロード向けの PostgreSQL 対応のフルマネージド データベース サービス。標準の PostgreSQL と比べて、トランザクション ワークロードのパフォーマンスが最大で 4 倍、分析クエリの処理速度が最大で 100 倍になります。AlloyDB for PostgreSQL は、ML 対応の自動パイロット システムによって管理を簡素化します。 |

データベースの選定

このセクションでは、システムをサポートするデータベースを選択するためのベスト プラクティスについて説明します。

マネージド データベース サービスの使用を検討する

独自のデータベースやデータベース クラスタをインストールする前に Google Cloud のマネージド データベース サービスについて検討してください。独自のデータベースをインストールすると、パッチやアップデートのインストール、モニタリングやバックアップなど日々の運用を管理するメンテナンス費用が発生します。

データベースの選択には、機能的および非機能的なアプリケーション要件を使用します。低レイテンシ アクセス、時系列データ処理、障害復旧、モバイル クライアントの同期を検討してください。

データベースを移行するには、次の表に示すプロダクトのいずれかを使用します。

| Database 移行プロダクト | 説明 |

|---|---|

| Cloud SQL | リモート リージョンのリードレプリカ、低レイテンシの読み取り、障害復旧をサポートするリージョン サービス。 |

| Spanner | 外部整合性、グローバル レプリケーション、99.999% のサービスレベル契約(SLA)を提供するマルチリージョン サービス。 |

| Bigtable | 最大 99.999% の可用性で大規模な分析ワークロードにも運用ワークロードにも対応できる、フルマネージドでスケーラブルな NoSQL データベース サービス。 |

| Memorystore | 2 つの一般的なオープン ソース キャッシュ ソリューションである Redis と Memcached のマネージド バージョンを提供するフルマネージド データベース サービス。 |

| Firebase Realtime Database | Firebase Realtime Database は、リアルタイムでデータを保存してユーザー間で同期できる、クラウドホスト型 NoSQL データベースです。 |

| Firestore | 自動スケーリングと高性能を実現し、アプリケーション開発を簡素化するように構築された NoSQL ドキュメント データベース。 |

| オープンソース | MongoDB や MariaDB などの代替データベース オプション。 |

データベースの移行

既存のワークロードを Google Cloud に移行する際にユーザーがアプリケーションのダウンタイムをゼロにするには、要件をサポートするデータベース技術を選択することが重要です。データベース移行オプションとベスト プラクティスについては、データベース移行ソリューションと同種データベースの移行のためのベスト プラクティスをご覧ください。

データベース移行の計画には、次の作業が含まれます。

- 現在のデータベースの評価と調査。

- 移行の成功基準の定義。

- 移行とターゲット データベースの環境設定。

- ターゲット データベースでのスキーマの作成。

- ターゲット データベースへのデータの移行。

- すべてのデータが正しく移行され、データベースに存在することを確認する移行の検証。

- ロールバック戦略の作成。

移行戦略を選択する

適切なターゲット データベースを選択することは、移行成功の重要な鍵となります。以下の表は、いくつかの使用例での移行戦略のオプションを示します。

| ユースケース | 推奨事項 |

|---|---|

| Google Cloud における新しいデプロイ | Cloud SQL、Spanner、Bigtable、Firestore のようなクラウド向けのマネージド データベースから、ユースケースの要件を満たすものを選んでください。 |

| リフト&シフト移行 | Cloud SQL、MYSQL、PostgreSQL、SQLServer のような互換性のあるマネージド データベース サービスを選んでください。 |

| アプリケーションで、Cloud SQL でサポートされていないデータベースに対するきめ細かいアクセスを必要とする | Compute Engine の VM でデータベースを実行します。 |

Memorystore を使用してキャッシュ保存データベース レイヤをサポートする

Memorystore は、数ミリ秒を下回るレイテンシをサポートするフルマネージドの Redis および Memcached データベースです。Memorystore は、オープンソースの Redis および Memcached と完全互換性があります。アプリケーションでこれらのキャッシュ保存データベースを使用する場合、コード内のアプリケーション レベルの変更をせずに Memorystore を使用できます。

ベアメタル サーバーを使用して Oracle データベースを運用する

ワークロードが Oracle データベースを必要とする場合、Google Cloud 提供のベアメタル サーバーを使用します。このアプローチはリフト&シフト移行戦略に該当します。

ワークロードを Google Cloud に移行して、ベースライン ワークロードが稼働した後にモダナイズする場合は、Spanner、Bigtable、Firestore などのマネージド データベース オプションの使用を検討してください。

クラウド用に構築されたデータベースは、クラウド インフラストラクチャ上にボトムアップして構築された、最新のマネージド データベースです。これらのデータベースではスケーラビリティや高可用性など、独自のデフォルト機能を使用できますが、独自のデータベースを運用する場合、その実現は困難です。

データベースをモダナイズする

クラウドで新しいアプリケーションを設計する場合、または既存のデータベースをクラウドに移行する場合でも、システム設計の早い段階でデータベース戦略をご検討ください。Google Cloud は、Cloud SQL for MySQL や Cloud SQL for PostgreSQL のようなオープンソース データベース向けのマネージド データベース オプションを提供します。この移行を、データベースをモダナイズし、将来のビジネスニーズに備える機会だと捉えましょう。

既製のアプリケーションで固定データベースを使用する

商用オフザシェルフ(COTS)アプリケーションは、固定型データベースと固定の構成を必要とします。リフト&シフトは、COTS アプリケーションに対して最適の移行アプローチです。

チームのデータベース移行スキルセットを確認する

チームのデータベース移行能力とスキルセットに基づいて、クラウド データベースを移行する方法を選択してください。Google Cloud Partner Advantage で移行全体をサポートするパートナーを探します。

HA と DR の要件を満たすデータベース設計

高可用性(HA)と障害復旧(DR)の要件を満たすようにデータベースを設計する場合、信頼性とコスト間のトレードオフを検討します。クラウド向けに構築されたデータベース サービスは、データベースと構成に応じて、リージョン内もしくはマルチリージョンにデータのコピーを複数作成します。

BigQuery や Spanner など、一部の Google Cloud サービスにはマルチリージョンのバリアントがあります。リージョンの障害に対する復元力を確保するため、可能であれば、マルチリージョン サービスを設計してください。

Google Cloud のマネージド データベースを使用せずに Compute Engine VM でデータベースを設計する場合は、データベースの複数のコピーを実行するようにしてください。詳細については、信頼性カテゴリのスケーラビリティと高可用性を実現する設計をご覧ください。

データ所在地をサポートする特定のクラウド リージョン

データ所在地とは、データが物理的に存在している場所のことです。データ所在地要件に基づいたデータベースをデプロイする特定のクラウド リージョンを選択することを検討してください。

マルチリージョンでデータベースをデプロイする場合、構成によってはリージョン間でデータ レプリケーションが行われる場合があります。保管時に希望のリージョン内にデータを保持する構成を選択してください。Spanner などの一部のデータベースでは、デフォルトでマルチリージョン レプリケーションを使用できます。リソース ロケーションの制約を含む組織のポリシーを設定して、データ所在地を適用することもできます。詳細については、リソース ロケーションの制限をご覧ください。

障害復旧を含むデータ所在地設計

データ所在地設計に目標復旧時間(RTO)と目標復旧時点(RPO)を含み、RTO / RPO と障害復旧ソリューション コスト間のトレードオフを検討します。RTO / RPO の数値が小さいほどコストは高くなります。中断から早く回復させたい場合、システム運用コストは高くなります。また、障害復旧アプローチと顧客の満足度を突き合わせ、信頼性への投資が適切かどうかを確認します。詳しくは、100% の信頼性を目指す必要はないと障害復旧プランニング ガイドをご覧ください。

データベースを Google Cloud 対応にする

ワークロードに合わせてデータベースを選択する場合、選択したサービスが運用されているリージョンやデータが物理的に保存されている場所のコンプライアンスを遵守していることを確認してください。Google の認証とコンプライアンス基準については、コンプライアンス状況をご覧ください。

暗号化

このセクションでは、暗号化の要件を特定し、システムをサポートする暗号鍵戦略を選択するためのベスト プラクティスについて説明します。

暗号化要件を決定する

暗号化要件は、企業のセキュリティ ポリシーやコンプライアンス要件などのさまざまな要因によって決定されます。Google Cloud に保存されているデータはすべて、静止時にデフォルトで AES256 を使用して暗号化されており、ユーザーの対応は不要です。詳細については、Google Cloud での保存時の暗号化をご覧ください。

暗号鍵に関する戦略を選択する

暗号鍵を自分で管理するかマネージド サービスを利用するか決めることができます。Google Cloud は両方のシナリオをサポートします。Google Cloud で暗号鍵を管理するためにフルマネージド サービスが必要な場合は、Cloud Key Management Service(Cloud KMS)を選択してください。ご自身で暗号鍵のライフサイクルをより詳細に管理したい場合は、顧客管理の暗号鍵(CMEK)を使用できます。

Google Cloud 外部で暗号鍵を作成し管理するには、次のオプションからひとつ選んでください。

- パートナー ソリューションを使用して鍵を管理する場合は、Cloud External Key Manager を使用します。

- オンプレミスで暗号鍵を管理し、その鍵を使用して Google Cloud 上のデータを暗号化したい場合は、暗号鍵を KMS 鍵もしくはハードウェア セキュリティ モジュール(HSM)鍵として Cloud KMS にインポートします。鍵を使用して Google Cloud 上のデータを暗号化します。

データベースの設計とスケーリング

このセクションでは、システムをサポートするデータベースを設計し、スケーリングするためのベスト プラクティスについて説明します。

モニタリング指標を使用してスケーリング ニーズを評価する

既存のモニタリング ツールや環境からの指標を使用して、データベースのサイズとスケーリングの要件(データベース インスタンスの適切なサイズ設定とスケーリング戦略の設計など)の基礎事項を理解します。

新しいデータベース設計では、提供されるアプリケーションから予測される負荷とトラフィック パターンに基づいてスケーリング数を決定します。詳細については、Cloud SQL インスタンスのモニタリング、Cloud Monitoring によるモニタリング、インスタンスのモニタリングをご覧ください。

ネットワーキングとアクセス

このセクションでは、システムをサポートするためのネットワークとアクセスを管理するためのベスト プラクティスについて説明します。

プライベート ネットワークでデータベースを運用する

プライベート ネットワークでデータベースを運用し、データベースにアクセスする必要のあるクライアントにのみ、制限されたアクセスを許可します。VPC 内に Cloud SQL インスタンスを作成できます。Google Cloud は、Spanner、Bigtable のデータベースに VPC Service Controls for Cloud SQL を提供し、これらのリソースへのアクセスが、承認された VPC ネットワークのクライアントだけに制限されるようにします。

ユーザーに最小限の権限を付与する

Identity and Access Management(IAM)はデータベース サービスを含む Google Cloud サービスへのアクセスをコントロールします。未承認のアクセスによるリスクを最小限に抑えるために、ユーザーに最小限の権限を付与します。データベースへのアプリケーション レベルのアクセスには、最小限の権限があるサービス アカウントを使用します。

自動化と適正サイズ設計

このセクションでは、自動化を定義し、システムをサポートするための適切なサイズを設定するためのベスト プラクティスについて説明します。

データベース インスタンスをコードとして定義する

Google Cloud に移行する利点の一つは、インフラストラクチャと、コンピューティングやデータベース レイヤなどのワークロードの他の側面における自動化の実現です。Google Deployment Manager や Terraform Cloud などのサードパーティ製ツールによって、データベース インスタンスをコードとして定義できます。これにより、データベースの作成と構成に対し、一貫した繰り返し可能なアプローチを適用できます。

Liquibase を使用してデータベースをバージョン管理する

Cloud SQL や Spanner のような Google データベース サービスは、データベースのためのオープンソース バージョン管理ツールである Liquibase をサポートしています。Liquibase は、データベース スキーマの変更を追跡、ロールバックし、反復可能な移行を実行します。

スケーリングをサポートするデータベースのテストと調整

データベース インスタンスで負荷テストを実行し、テスト結果に基づいてアプリケーションの要件を満たすように調整します。データベースの初期スケールは、重要業績評価指標(KPI)の負荷テストのに基づいて判断するか、現在のデータベースから取得したモニタリング KPI を使用して決定します。

データベース インスタンスを作成するときは、テスト結果または過去のモニタリング指標に基づくサイズから始めます。クラウドで予想される負荷でデータベース インスタンスをテストします。次に、データベース インスタンスの予想される負荷に対して必要な結果が得られるまでインスタンスを微調整します。

スケーリング要件に適したデータベースを選択する

データベースのスケーリングは、コンピューティング レイヤ コンポーネントのスケーリングとは異なります。データベースには状態があります。データベースの 1 つのインスタンスで負荷を処理できない場合は、データベース インスタンスをスケーリングするための適切な戦略を検討してください。スケーリング戦略はデータベースの種類によって異なります。

次の表に、スケーリングのユースケースに対応する Google プロダクトを示します。

| ユースケース | 推奨プロダクト | 説明 |

|---|---|---|

| 処理能力とストレージをスケールアップする必要がある場合は、データベースにノードを追加して、データベース インスタンスを水平方向にスケーリングします。 | Spanner | クラウド用に構築されたリレーショナル データベース。 |

| ノードを追加してデータベースをスケールします。 | Bigtable | フルマネージドの NoSQL ビッグデータ データベース サービス。 |

| データベース スケーリングを自動的に処理します。 | Firestore | モバイル、ウェブ、サーバー開発向けの柔軟でスケーラブルなデータベース。 |

| より多くのクエリを処理するには、Cloud SQL データベース インスタンスを垂直方向にスケールアップしてコンピューティング容量とメモリ容量を増やします。Cloud SQL ではストレージ レイヤはデータベース インスタンスから分離されています。ストレージ容量が容量に近づくたびに、ストレージ レイヤを自動的にスケーリングできます。 | Cloud SQL | リレーショナル データベースの設定、維持、管理、運営をサポートする Google Cloud 上のフルマネージド データベース サービス。 |

運用

このセクションでは、システムをサポートするための運用のベスト プラクティスについて説明します。

Cloud Monitoring を使用してデータベースをモニタリングし、アラートを設定する

Cloud Monitoring を使用してデータベース インスタンスのモニタリングとイベントの適切なチームを知らせるアラートの設定を行う。効果的なアラートのベスト プラクティスについては、効率的なアラートを作成するをご覧ください。

クラウド用に構築されたすべてのデータベースは、ロギングとモニタリングの指標を提供します。各サービスは、ロギングとモニタリングの指標を可視化するためのダッシュボードを提出します。すべてのサービスのモニタリング指標は、Google Cloud のオペレーション スイートと統合されています。Spanner は、デバッグと根本原因の分析のために Key Visualizer のようなクエリ イントロスペクション ツールを提供します。Key Visualizer の機能は次のとおりです。

- データベース用のビジュアル レポートを生成することで、Spanner 使用パターンの分析をサポートします。レポートは使用パターンを時系列で行の範囲別に表示します。

- 使用パターンの大規模な分析情報を提供します。

Bigtable には、Bigtable インスタンスの使用パターンの分析に役立つ Key Visualizer 診断ツールも用意されています。

ライセンス

このセクションでは、システムをサポートするライセンスのベスト プラクティスについて説明します。

オンデマンド ライセンスか既存のライセンスかを選択する

Cloud SQL for SQL Server を使用したい場合、お客様所有ライセンスの使用はサポートされていません。ライセンス費用はコアタイムごとの使用量に基づいています。

既存の Cloud SQL for SQL Server ライセンスを使用したい場合は、Compute VM で Cloud SQL for SQL Server を実行することを検討してください。詳細については、Microsoft ライセンスとオンデマンド ライセンスか既存ライセンスの使用かを選択するをご覧ください。

Oracle を使用していて、Oracle 向け Bare Metal Solution に移行する場合は、お客様所有ライセンスを使用できます。詳細については、Bare Metal Solution を計画するをご覧ください。

移行のタイムライン、方法、ツールセット

このセクションでは、システムをサポートするデータベースの移行を計画およびサポートするためのベスト プラクティスについて説明します。

データベースのモダナイゼーションの準備状況を判断する

組織がデータベースをモダナイズし、クラウド用に構築されたデータベースを使用する準備ができているかどうかを評価します。

モダナイゼーションはアプリケーション側に影響する可能性があるため、ワークロードの移行タイムラインを計画する場合は、データベースのモダナイゼーションを検討してください。

ステークホルダーを移行計画に関与させる

データベースの移行では、次のことを行います。

- ターゲット データベースを設定する。

- スキーマを変換する。

- ソース データベースとターゲット データベースの間のデータ レプリケーションを設定する。

- 移行中に発生した問題をデバッグする。

- アプリケーション レイヤとデータベースの間のネットワーク接続を確立する。

- ターゲット データベース セキュリティを実装する。

- アプリケーションがターゲット データベースに接続していることを確認する。

多くの場合、これらのタスクではさまざまなスキルセットが必要であり、組織内の複数のチームが協力して移行を完了します。移行を計画するときに、アプリ デベロッパー、データベース管理者、インフラストラクチャ チームやセキュリティ チームなど、すべてのチームの関係者を含めます。

チームにこのタイプの移行をサポートするスキルがない場合は、Google のパートナーが移行を支援します。詳細については、Google Cloud Partner Advantage をご覧ください。

同種移行と異種移行のためのツールセットを特定する

同機種の移行とは、同じデータベース テクノロジーを使用するソース データベースとターゲット データベースの間のデータベースの移行です。異機種の移行とは、ターゲット データベースがソース データベースと異なる場合の移行です。

異機種の移行では、通常、ソース データベースからターゲット データベースのエンジンタイプへのスキーマ変換が必要になります。スキーマ変換はソース データベース スキーマの複雑さに依存するため、データベース チームは関連する課題を評価する必要があります。

データ移行の各ステップのテストと検証

データの移行には複数の手順が必要です。移行エラーを最小限に抑えるには、次のステップに進む前に移行の各ステップをテストして検証します。移行プロセスを促進する要因は次のとおりです。

- 移行が同種か異種か。

- 移行の実行に必要なツールやスキルセットのタイプ。

- 異機種移行の場合、ターゲット データベース エンジンの経験。

継続的なデータ レプリケーションの要件を決定する

最初にデータを移行し、その後、ソースからターゲット データベースにデータを継続的にレプリケートする計画を作成します。ターゲットが安定し、アプリケーションが新しいデータベースに完全に移行されるまでレプリケーションを続行します。この計画は、データベースの切り替え中に発生する可能性のあるダウンタイムを特定し、それに応じて計画を立てるのに役立ちます。

データベース エンジンを Cloud SQL、Cloud SQL for MySQL、または Cloud SQL for PostgreSQL から移行する場合、Database Migration Service を使用して、フルマネージドの方法でこのプロセスを自動化します。他の種類の移行をサポートするサードパーティ ツールについては、Cloud Marketplace をご覧ください。

推奨事項

アーキテクチャ フレームワークのガイダンスを独自の環境に適用するには、次のことをおすすめします。

データベースのマルチテナンシーでは、複数のお客様のデータを共有インフラストラクチャ(この場合はデータベース)に保存します。SaaS(Software as a Service)ベースのサービスをお客様に提供する場合は、さまざまな顧客に属するデータセットを論理的に分離し、そのアクセスをサポートする方法を理解する必要があります。また、分離レベルに基づいて要件を評価します。

Spanner や Cloud SQL などのリレーショナル データベースには、データベース インスタンス レベル、データベース レベル、スキーマレベル、またはデータベース テーブルレベルなど、複数のアプローチがあります。他の設計上の決定と同様に、隔離度と費用やパフォーマンスなどの他の要因との間にはトレードオフがあります。IAM ポリシーではデータベース インスタンスへのアクセスを制御します。

データモデルの要件に適したデータベースを選択します。

適切なキー値を選択してキーのホットスポット化を回避します。ホットスポットは、テーブル内で他のロケーションよりも多くのアクセスがあるロケーションのことです。ホットスポットについては、スキーマ設計ベスト プラクティスをご覧ください。

可能な限りデータベース インスタンスをシャーディングします。

接続プーリングや指数バックオフなどの接続管理ベスト プラクティスを使用します。

あまりにも大規模なトランザクションは避けてください。

データベースのメンテナンス更新に対するアプリケーションのレスポンスを設計し、テストします。

データベースへの接続を保護し、分離します。

データベースのサイズ指定と成長の期待値によって、データベースが要件をサポートするようにします。

HA と DR のフェイルオーバー戦略をテストします。

処理に慣れるために、バックアップと復元、エクスポートとインポートを実行します。

Cloud SQL の推奨事項

- プライベート IP アドレス ネットワーキング(VPC)を使用します。セキュリティを強化するため、次の点を考慮してください。

- Cloud SQL Auth Proxy を使用してプライベート ネットワーキングをサポートします。

- パブリック IP アドレスのアクセス

constraints/sql.restrictPublicIpを制限します。

- パブリック IP アドレス ネットワーキングが必要な場合は、次の点を考慮してください。

- 組み込みファイアウォールで制限付きの IP アドレスリストを使用し、Cloud SQL インスタンスの受信接続で SSL の使用を必須にします。詳しくは、SSL / TLS 証明書の構成をご覧ください。

- セキュリティを強化するため、次の点を考慮してください。

- 汎用アクセス権を付与するのではなく、Cloud SQL Auth プロキシを使用してください。

- 承認済みネットワークを制限します(

constraints/sql.restrictAuthorizedNetworks)。

- データベース ユーザーの権限を制限します。

次のステップ

以下をはじめとするデータ分析のベスト プラクティスについて学びます。

- データ分析の基本原則と Google Cloud 主要サービスについて学習する。

- データ ライフサイクルについて学習する。

- データの取り込み方法を学習する。

- データ ストレージを選択して管理する。

- データを処理して変換する。

アーキテクチャ フレームワークの他のカテゴリ(信頼性、オペレーショナル エクセレンス、セキュリティ、プライバシー、コンプライアンスなど)を確認する。

データを分析する

Google Cloud Architecture Framework のこのドキュメントでは、Google Cloud におけるデータ分析の基本原則とベスト プラクティスについて説明します。さらに、主要なデータ分析サービスの詳細と、これらのサービスがデータ ライフサイクルのさまざまな段階でどのように役立つかについて説明します。これらのベスト プラクティスは、データ分析のニーズを満たし、システム設計を作成する際に役立ちます。

基本原則

どの企業も、データを分析して、その結果から行動につながるインサイトを得たいと考えています。Google Cloud では、データの取り込みからレポートや可視化まで、データのライフサイクル全体をサポートするさまざまなサービスを提供しています。これらのサービスのほとんどはフルマネージド サービスであり、一部はサーバーレスです。Apache Hadoop または Beam をセルフホストするなど、Compute Engine VM 上にデータ分析環境を構築し、管理することもできます。

特定の重点分野、チームの専門知識、戦略的視点があれば、データ分析のニーズに対応するためにどの Google Cloud サービスを採用するかを判断するのに役立ちます。たとえば、Dataflow ではサーバーレス アプローチで複雑な変換を記述できますが、コンピューティングと処理のニーズに対応する独自のバージョンの構成を使用する必要があります。または、Dataproc を使用しても同じ変換を実行できますが、クラスタの管理やジョブの微調整は自分自身で行います。

システム設計では、抽出 / 加工 / 読み込み(ETL)や抽出 / 読み込み / 変換(ELT)など、自社のチームで採用する処理戦略を検討します。また、バッチ分析またはストリーミング分析のどちらが必要かも考慮する必要があります。Google Cloud では、統合されたデータ プラットフォームを提供しているため、これにより、ビジネスの要件に合わせてデータレイクやデータ ウェアハウスを構築できます。

主なサービス

次の表に、Google Cloud の分析サービスの概要を示します。

| Google Cloud サービス | 説明 |

|---|---|

| Pub/Sub | ストリーム分析とイベント ドリブン コンピューティング システム向けの、シンプルで信頼性の高いスケーラブルな基盤。 |

| Dataflow | ストリーム(リアルタイム)モードとバッチ(履歴)モードでデータを変換、拡張するフルマネージド サービス。 |

| Dataprep by Trifacta | 分析用の構造化データと非構造化データを視覚的に探索、クリーニング、準備できるインテリジェント データサービス。 |

| Dataproc | 高速で使いやすいフルマネージド クラウド サービスであり、Apache Spark クラスタと Apache Hadoop クラスタを実行します。 |

| Cloud Data Fusion | クラウド向けに構築されたフルマネージドのデータ統合サービス。ETL/ELT データ パイプラインを構築し、管理できます。Cloud DataFusion は、グラフィカルなインターフェースや、事前構成されたコネクタと変換を含む幅広いオープンソース ライブラリを提供します。 |

| BigQuery | ストレージと処理能力のニーズに合わせてスケールする、Google のフルマネージドで低コストのサーバーレス データ ウェアハウスです。BigQuery では、テラバイト規模からペタバイト規模のデータを分析できるカラム型の ANSI SQL データベースを利用できます。 |

| Cloud Composer | フルマネージドなワークフロー オーケストレーション サービス。クラウドとオンプレミス データセンターにまたがるパイプラインの作成、スケジューリング、モニタリングを実現します。 |

| Data Catalog | フルマネージドでスケーラブルなメタデータ管理サービス。すべてのデータをすばやく検出、管理、把握できます。 |

| Looker Studio | インタラクティブなダッシュボードを通じてデータから分析情報を引き出すために役立つ、フルマネージド ビジュアル分析サービス。 |

| Looker | マルチクラウド環境でデータを接続、分析、可視化するエンタープライズ プラットフォーム。 |

| Dataform | データ パイプラインのコラボレーション、作成、デプロイを行い、データ品質の確保に役立つフルマネージド プロダクト。 |

| Dataplex | 一貫性のあるコントロールを使用して、データレイク、データ ウェアハウス、データマートのデータを横断的に管理、モニタリング、運営するマネージド データレイク サービス。 |

| AnalyticsHub | 組織全体でデータ分析アセットを効率的かつ安全に交換し、データの信頼性とコストの課題を解決できるプラットフォーム。 |

データ ライフサイクル

システム設計の段階で、任意のシステムまたはデータ ライフサイクルでの一般的なデータ移動を中心に、Google Cloud データ分析サービスをグループ化できます。

データ ライフサイクルには、次のステージとサンプル サービスが含まれます。

- 取り込みには、Pub/Sub、Storage Transfer Service、Transfer Appliance、BigQuery などのサービスが含まれます。

- ストレージには、Cloud Storage、Bigtable、Memorystore、BigQuery などのサービスが含まれます。

- 処理と変換には、Dataflow、Dataproc、Dataprep、センシティブ データの保護、BigQuery などのサービスが含まれます。

- 分析とウェアハウジングには、BigQuery などのサービスが含まれます。

- レポートと可視化には、Looker Studio や Looker などのサービスが含まれます。

次のステージとサービスが、データ ライフサイクル全体を通して実行されます。

- データ統合には、Data Fusion などのサービスが含まれます。

- メタデータの管理とガバナンスには、Data Catalog などのサービスが含まれます。

- ワークフロー管理には、Cloud Composer などのサービスが含まれます。

データの取り込み

以下に挙げるデータの取り込みのベスト プラクティスを、実際の環境に適用します。

取り込むデータソースを特定する

通常、データは別のクラウド プロバイダまたはサービスから、またはオンプレミスのロケーションから提供されます。

他のクラウド プロバイダからデータを取り込むには、通常、Cloud Data Fusion、Storage Transfer Service、または BigQuery 転送サービスを使用します。

オンプレミスのデータの取り込みでは、取り込むデータの量とチームのスキルセットを考慮してください。チームでローコードのグラフィカル ユーザー インターフェース(GUI)を使用したい場合は、Cloud Data Fusion と Java Database Connectivity(JDBC)などの適切なコネクタを使用します。大量のデータを処理する場合は、Transfer Appliance や Storage Transfer Service を使用できます。

取り込み後にデータをどのように処理するかを検討してください。たとえば、Storage Transfer Service は Cloud Storage バケットにのみデータを書き込みますが、BigQuery Data Transfer Service は BigQuery データセットにのみデータを書き込みます。Cloud Data Fusion は複数の宛先をサポートしています。

ストリーミング データソースまたはバッチ データソースを特定する

データの使用方法のニーズを考慮し、ストリーミングまたはバッチのユースケースの場所を特定します。たとえば、グローバル ストリーミング サービスを低レイテンシで実行する必要がある場合は、Pub/Sub を使用できます。分析やレポート作成で使用するデータが必要な場合は、データを BigQuery にストリーミングできます。

オンプレミスまたは他のクラウド環境で Apache Kafka などのシステムからデータをストリーミングする必要がある場合は、Kafka to BigQuery Dataflow テンプレートを使用します。バッチ ワークロードの場合、最初のステップは通常、Cloud Storage へのデータの取り込みになります。データの取り込みには gsutil ツールまたは Storage Transfer Service を使用します。

自動化ツールでデータを取り込む

他のシステムからクラウドに手動でデータを移動するのは容易なことではありません。可能であれば、データ取り込みプロセスの自動化が可能なツールを使用してください。たとえば、Cloud Data Fusion の場合、GUI のドラッグ&ドロップ操作で外部ソースからデータを取り込めるコネクタやプラグインが用意されています。チームでコードを作成する場合は、Data Flow または BigQuery でデータの取り込みを自動化できます。Pub/Sub は、ローコードまたはコードファーストのアプローチで役立ちます。データサイズが 1 TB までであれば、gsutil を使用して、データをストレージ バケットに取り込みます。取り込むデータ量が 1 TB を超える場合は、Storage Transfer Service を使用します。

移行ツールを使用して別のデータ ウェアハウスから取り込む

Teradata、Netezza、Redshift など、別のデータ ウェアハウス システムからの移行が必要な場合は、BigQuery Data Transfer Service の移行支援を利用できます。BigQuery Data Transfer Service は、スケジュールに従って外部ソースからデータを取り込むことができるサードパーティ転送も提供しています。詳細については、各データ ウェアハウスの詳細な移行方法をご覧ください。

データ取り込みの要件を評価する

取り込む必要があるデータの量は、システム設計で使用するサービスを決定するのに役立ちます。データをストリーミングで取り込む場合、Pub/Sub では 1 秒あたり数十ギガバイトにスケーリングされます。データの容量、ストレージ、リージョンの要件は、Pub/Sub Lite がシステム設計に適しているかどうかの判断に役立ちます。詳細については、Pub/Sub または Pub/Sub Lite の選択をご覧ください。

データのバッチ取り込みでは、転送するデータの合計量と転送速度も評価します。時間の見積もりやオンライン転送とオフライン転送の比較など、利用可能な移行オプションを確認してください。

適切なツールを使用してスケジュールに沿って定期的にデータを取り込む

Storage Transfer Service と BigQuery Data Transfer Service のどちらも、取り込みジョブをスケジュールで実行できます。取り込みのタイミング、または送信元と宛先のシステムを詳細に制御するには、Cloud Composer のようなワークフロー管理システムを使用します。手動のアプローチが必要な場合は、Cloud Scheduler と Pub/Sub を使用して Cloud Functions の関数をトリガーします。

コンピューティング インフラストラクチャを管理し、最大 1 TB のデータ転送を行う場合は、cron とともに gsutil コマンドを使用できます。Cloud Composer ではなく、この手動アプローチを使用する場合は、本番環境への転送スクリプトの作成に関するベスト プラクティスに従ってください。

FTP / SFTP サーバーのデータ取り込みの要件を確認する

FTP / SFTP サーバーからデータを取り込む際にコードフリーの環境が必要な場合は、FTP コピー プラグインを使用できます。長期的なワークフロー ソリューションをモダナイズして作成する場合、Cloud Composer はさまざまなソースやシンクからの読み取りと書き込みが可能なフルマネージド サービスです。

Apache Kafka コネクタを使用してデータを取り込む

Pub/Sub、Dataflow、BigQuery のいずれかを使用している場合、いずれかの Apache Kafka コネクタを使用してデータを取り込めます。たとえば、オープンソースの Pub/Sub Kafka コネクタを使用すると、Pub/Sub または Pub/Sub Lite からデータを取り込むことができます。

参考情報

- Cloud Storage Transfer Service エージェントのベスト プラクティス

- BigQuery にデータを取り込み、分析できるようにする方法

- Cloud Data Fusion を使用した臨床データと業務データの取り込み

- 分析イベントとログの大規模取り込みの最適化

データ ストレージ

以下に挙げるデータ ストレージのベスト プラクティスを実際の環境に適用します。

ニーズに適したデータストアを選択する

使用するストレージ ソリューションのタイプを選択するには、データのダウンストリームの使用状況を確認して把握します。このデータの一般的なユースケースを次に示します。これにより、使用する Google Cloud プロダクトに関する推奨事項が提供されます。

| データのユースケース | 推奨のプロダクト |

|---|---|

| ファイルベース | Filestore |

| オブジェクトベース | Cloud Storage |

| 低レイテンシ | Bigtable |

| 時系列 | Bigtable |

| オンライン キャッシュ | Memorystore |

| トランザクション処理 | Cloud SQL |

| ビジネス インテリジェンス(BI)と分析 | BigQuery |

| バッチ処理 | Cloud Storage Bigtable(受信データが時系列で、低レイテンシのアクセスが必要な場合) BigQuery(SQL を使用する場合)。 |

データ構造の要件を確認する

非構造化データ(ドキュメント、テキスト ファイル、音声ファイル、動画ファイル、ログなど)の場合、通常はオブジェクト ベースのストアが最適な選択肢となります。必要に応じて、オブジェクト ストレージからデータを読み込んで処理できます。

XML や JSON などの半構造化データの場合は、ユースケースとデータアクセス パターンを利用して選択肢を確認してください。このようなデータセットを BigQuery に読み込むと、スキーマの自動検出が可能になります。低レイテンシが要求される場合は、JSON データを Bigtable に読み込むことができます。従来の要件がある場合や、アプリケーションがリレーショナル データベースに対応している場合は、リレーション ストアにデータセットを読み込むこともできます。

CSV、Parquet、Avro、ORC などの構造化データは BigQuery で使用できます(SQL を使用する BI 要件と分析要件がある場合)。詳細については、データのバッチ読み込み方法をご覧ください。オープン標準とテクノロジーでデータレイクを作成する場合は、Cloud Storage を使用できます。

データを移行して HDFS のコストを削減する

Hadoop 分散ファイル システム(HDFS)のデータをオンプレミスまたは他のクラウド プロバイダからより低価格なオブジェクト ストレージ システムに移動する方法について説明します。Cloud Storage は代替のデータストアとして多くの企業で選択されています。この選択のメリットとデメリットの詳細については、HDFS と Cloud Storage の比較をご覧ください。

push または pull 方式でデータを移動できます。どちらのメソッドでも hadoop

distcp コマンドを使用します。詳しくは、オンプレミスから Google Cloud への HDFS データの移行をご覧ください。

オープンソースの Cloud Storage コネクタを使用して、Hadoop と Spark ジョブが Cloud Storage 内のデータにアクセスできるようにすることもできます。デフォルトでは、コネクタが Dataproc クラスタにインストールされます。これは、他のクラスタに手動でインストールできます。

オブジェクト ストレージを使用して統一性のあるデータレイクを構築する

データレイクは、大量の構造化データ、半構造化データ、非構造化データを保存、処理、保護するための、一元化されたリポジトリです。Cloud Composer と Cloud Data Fusion を使用してデータレイクを構築できます。

最新のデータ プラットフォームを構築するには、Cloud Storage の代わりに BigQuery を中央データソースとして使用します。BigQuery は、ストレージとコンピューティングを分離した最新のデータ ウェアハウスです。BigQuery で構築されたデータレイクを使用すると、Cloud Console で BigQuery から従来の分析を実行できます。また、Apache Spark などの他のフレームワークから保存されているデータにアクセスすることもできます。

参考情報

- Cloud Storage のベスト プラクティス

- Cloud Storage のコスト最適化に関するベスト プラクティス

- Cloud Storage でデータのプライバシーとセキュリティを確保するためのベスト プラクティス

- Memorystore のベスト プラクティス

- BigQuery でのストレージの最適化

- Bigtable のスキーマ設計

データを処理して変換する

データを処理して変換するときに、実際の環境に独自のデータ分析に関する以下のベスト プラクティスを適用します。

Google Cloud で使用できるオープンソース ソフトウェアについて確認する

多くの Google Cloud サービスは、オープンソース ソフトウェアを使用して移行をシームレスに行います。Google Cloud は、Open API を使用して、オープンソース フレームワークと互換性があるマネージド ソリューションとサーバーレス ソリューションを提供し、ベンダー ロックインを削減します。

Dataproc は、操作の負荷がほとんどなく、オープンソース ソフトウェアをホストできる Hadoop 対応のマネージド サービスです。Dataproc は、Spark、Hive、Pig、Presto、Zookeeper をサポートしています。また、Hive メタストアをマネージド サービスとして提供し、Hadoop エコシステム内の単一障害点をなくします。

現在、Apache Beam をバッチおよびストリーミング処理エンジンとして使用している場合は、Dataflow に移行できます。Dataflow は、Apache Beam を使用するフルマネージドのサーバーレス サービスです。Dataflow を使用して Beam にジョブを作成しますが、Google Cloud で実行環境を管理します。

データ統合プラットフォームとして CDAP を使用している場合は、Cloud Data Fusion に移行してフルマネージド エクスペリエンスを実現できます。

ETL または ELT のデータ処理要件を特定する

チームの経験と好みは、データ処理の方法に関するシステム設計の決定に役立ちます。Google Cloud では、従来の ETL または最新の ELT データ処理システムのいずれかを使用できます。

ETL パイプラインでは、Data Fusion、Dataproc、Dataflow のいずれかを使用できます。

- 新しい環境では、バッチとストリーミングのアプリケーションを統合する方法として Dataflow をおすすめします。

- Data Fusion のフルマネージド アプローチでは、ドラッグ&ドロップの GUI を使用してパイプラインを作成できます。

ELT パイプラインには、バッチとストリーミングの両方のデータ読み込みをサポートする BigQuery を使用します。BigQuery にデータを保存したら、SQL を使用してすべての変換を行い、ビジネス ユースケースで新しいデータセットを導出します。

ETL から ELT に移行してモダナイズする場合は、Dataform を使用できます。BigQuery で BI をサポートするには、Fivetran などのサードパーティ サービスも使用できます。

データのユースケースに適したフレームワークを使用する

使用するツールとフレームワークは、データのユースケースによって異なります。一部の Google Cloud プロダクトは、以下のすべてのデータ ユースケースを処理するように構築されていますが、他のユースケースでは特定のユースケースしかサポートされない場合があります。

- バッチデータ処理システムの場合、使い慣れた SQL インターフェースを使用して BigQuery でデータの処理と変換を行います。既存のパイプラインが Apache Hadoop または Spark のオンプレミス、または別のパブリック クラウドで実行されている場合は、Dataproc を使用できます。

- また、Dataflow では、バッチとストリーミングの両方のユースケースに統一されたプログラミング インターフェースを使用できます。そのため、ETL には Dataflow を、ELT には BigQuery をモダナイズして使用することをおすすめします。

ストリーミング データ パイプラインでは、ウィンドウ処理、自動スケーリング、テンプレートを提供する Dataflow などのマネージドでサーバーレスのサービスを使用します。詳細については、Dataflow を使用した本番環境データ パイプラインの構築をご覧ください。

- 分析と SQL に重点を置いたチームと機能がある場合は、BigQuery にデータをストリーミングすることもできます。

時系列分析やストリーミング動画分析など、リアルタイムのユースケースの場合は、Dataflow を使用します。

実行エンジンを将来にわたって管理する

ベンダーのロックインを最小限に抑え、将来別のプラットフォームを使用できるようにするには、Apache Beam プログラミング モデルおよび Dataflow をマネージド サーバーレス ソリューションとして使用します。Beam プログラミング モデルを使用すると、Dataflow から Apache Flink または Apache Spark への変更など、基盤となる実行エンジンを変更できます。

Dataflow を使用して複数のソースからデータを取り込む

Pub/Sub、Cloud Storage、HDFS、S3、Kafka などの複数のソースからデータを取り込むには、Dataflow を使用します。Dataflow は Dataflow テンプレートをサポートするマネージド サーバーレス サービスで、さまざまなツールからテンプレートを実行できます。

Dataflow Prime は、パイプラインの実行プロセスで使用されるマシンの水平および垂直の自動スケーリングを提供します。また、問題を特定して修正する方法を提案するスマートな診断と最適化案も示します。

機密データの検出、識別、保護を行う

機密データ保護を使用して、構造化データと非構造化データを検査し、変換します。機密データ保護は、Cloud Storage やデータベースなど、Google Cloud のあらゆる場所にあるデータに対応しています。ダウンストリームの処理で機密データを安全に使用し続けるために、機密データの分類、マスキング、トークン化を行うことができます。機密データ保護を使用して、BigQuery データのスキャンや大規模なデータセットの PII の匿名化と再識別を行います。

データ変換プロセスをモダナイズする

Dataform を使用してデータ変換をコードとして書き込み、デフォルトでバージョン管理の使用を開始します。また、CI / CD、単体テスト、バージョン管理などのソフトウェア開発のベスト プラクティスを SQL コードにも採用できます。Dataform は、PostgreSQL など、主要なクラウド データ ウェアハウス プロダクトとデータベースをすべてサポートしています。

参考情報

- Dataproc

- Dataflow

- Data Fusion

- BigQuery

- Dataform

- 機密データ保護

データ分析とウェアハウス

独自のデータ分析とウェアハウスのベスト プラクティスを実際の環境に適用します。

データ ストレージの要件を確認する

データレイクとデータ ウェアハウスは相互に排他的ではありません。データレイクは、非構造化および半構造化データの保存と処理に役立ちます。データ ウェアハウスは分析と BI に最適です。

データの要件を調査して、データの保存場所と、データの処理および分析に最適な Google Cloud プロダクトを判断します。BigQuery などのプロダクトは PB 単位のデータ処理が可能で、要件に合わせて拡張できます。

従来のデータ ウェアハウスから BigQuery に移行する機会を特定する

お客様の環境で現在使用されている従来のデータ ウェアハウスを確認します。複雑さを解消し、可能であれば費用を削減するために、従来のデータ ウェアハウスを BigQuery などの Google Cloud サービスに移行する機会を特定します。詳細とサンプル シナリオについては、BigQuery へのデータ ウェアハウスの移行をご覧ください。

データへの連携アクセスを計画する

データの要件と、他のプロダクトやサービスと連携する方法を確認します。データ連携の要件を特定し、適切なシステム設計を作成します。

たとえば、BigQuery では、Bigtable、Cloud SQL、Cloud Storage、Google ドライブなどの他のソースからデータを読み取ることができる外部テーブルを定義できます。これらの外部ソースは、BigQuery に保存するテーブルと結合できます。

BigQuery Flex Slots を使用してオンデマンドのバースト機能を提供する

実験的分析や探索的分析で多くのコンピューティング リソースが必要になり、追加容量が必要になることがあります。BigQuery では、Flex Slots の形式で追加のコンピューティング容量を取得できます。これらの Flex Slots は、需要の多い時期や重要な分析を完了する必要がある場合に役立ちます。

BigQuery に移行する際のスキーマの違いについて

BigQuery は、スタースキーマとスノーフレーク スキーマの両方をサポートしていますが、デフォルトではネストされたフィールドと繰り返しフィールドを使用します。ネストされたフィールドと繰り返しフィールドは、他のスキーマよりも読みやすく、相関関係がある場合もあります。データがスタースキーマまたはスノーフレーク スキーマで表現されているときに、BigQuery への移行を検討する場合は、システム設計を見直し、プロセスや分析に必要な変更を行ってください。

参考情報

- BigQuery でのマルチテナント ワークロードに関するベスト プラクティス

- BigQuery の行レベルのセキュリティに関するベスト プラクティス

- BigQuery の実体化されたビューのベスト プラクティス

レポートと可視化

レポート作成と可視化に関する以下のベスト プラクティスを実際の環境に適用します。

BigQuery BI Engine を使用してデータを可視化する

BigQuery BI Engine は高速なインメモリ分析サービスです。BI Engine を使用すると、BigQuery に保存されたデータを分析できます。クエリのレスポンス時間は 1 秒未満で、同時実行性にも優れています。BI Engine は、BigQuery API に統合されています。BI Engine の予約済みの容量を使用して、必要に応じてオンデマンド料金または定額料金を管理します。BI Engine は、1 秒未満のレスポンス時間を必要とする他の BI アプリケーションやカスタム ダッシュボード アプリケーションと連携できます。

Looker を使用して BI プロセスをモダナイズする

Looker は、BI、データ アプリケーション、埋め込み分析向けの最新のエンタープライズ プラットフォームです。データから整合性のあるデータモデルを高速かつ正確に作成でき、トランザクション データストアや分析データストア内のデータにアクセスできます。Looker では、複数のデータベースとクラウドでデータを分析することもできます。既存の BI プロセスとツールがある場合は、Looker などの中央のプラットフォームをモダナイズして使用することをおすすめします。

参考情報

- データ ウェアハウスの BigQuery への移行: レポートと分析

- Google Cloud 上の Hadoop に可視化ソフトウェアを接続するためのアーキテクチャ

- BI Engine で BigQuery の短いクエリを高速化

ワークフロー管理ツールを使用する

データ分析には、多くのプロセスとサービスが含まれます。データ分析のライフサイクル中に、さまざまなツールと処理パイプラインの間をデータが移動します。エンドツーエンドのデータ パイプラインを管理および維持するには、適切なワークフロー管理ツールを使用します。Cloud Composer は、オープンソースの Apache Airflow プロジェクトに基づくフルマネージドのワークフロー管理ツールです。

Cloud Composer を使用して Dataflow パイプラインを起動し、Dataproc ワークフロー テンプレートを使用できます。Cloud Composer は、DAG をテスト、同期、デプロイするための CI / CD パイプラインの作成や、データ処理ワークフローでの CI / CD パイプラインの使用にも役立ちます。詳細については、Cloud Composer: 開発のベスト プラクティスをご覧ください。

移行に関するリソース

すでにデータ分析プラットフォームを実行していて、ワークロードの一部またはすべてを Google Cloud に移行する場合は、次の移行リソースでベスト プラクティスとガイダンスを確認してください。

- 移行に関する一般的なガイダンス

- Cloud Storage の移行

- Pub/Sub の移行

- Bigtable の移行

- Dataproc の以降

- BigQuery の移行

- Composer の移行

次のステップ

Google Cloud AI と機械学習のシステム設計について、次のようなベスト プラクティスについて学習する。

- システム設計をサポートする Google Cloud AI と機械学習サービスについて学習する。

- ML データ処理のベスト プラクティスを確認する。

- モデルの開発とトレーニングのベスト プラクティスについて学習する。

アーキテクチャ フレームワークの他のカテゴリ(信頼性、オペレーショナル エクセレンス、セキュリティ、プライバシー、コンプライアンスなど)を確認する。

ML を導入する

Google Cloud Architecture Framework のこのドキュメントでは、Google Cloud におけるデータ分析の基本原則とベスト プラクティスについて説明します。主要な AI サービスと機械学習(ML)サービスと、それらが AI と ML のライフサイクルのさまざまな段階でどのように役立つかについて説明します。以下のベスト プラクティスは、AI と ML のニーズを満たし、システム設計を作成するのに役立ちます。このドキュメントは AI と ML の基本的なコンセプトを理解していることを前提としています。

Google Cloud で ML モデルを構築する際の開発プロセスを簡素化してオーバーヘッドを最小限に抑えるには、ユースケースに対して意味がある最高レベルの抽象化を検討します。抽象化のレベルは、システムを考えるまたはプログラムする複雑さの度合いとして定義されます。抽象化レベルが高いほど、閲覧者が認識できる細部は少なくなります。

ビジネスのニーズに基づいて Google AI や ML サービスを選択するには、次の表を使用します。

| ペルソナ | Google サービス |

|---|---|

| ビジネス ユーザー | Contact Center AI Insights、Document AI、ディスカバリ AI、Cloud Healthcare API などの標準ソリューション。 |

| ML の経験があまりないデベロッパー | 事前トレーニング済み API が、視覚、動画、自然言語などの一般的な知覚タスクに対処します。これらの API は、事前トレーニング済みモデルでサポートされており、デフォルトの検出項目を提供します。これらの API は、ML の専門知識やモデルの開発作業なしですぐに使用できます。トレーニング済みの API には、Vision API、Video API、Natural Language API、Speech-to-Text API、Text-to-Speech API、Cloud Translation API などがあります。 |

| デベロッパーのための生成 AI | Vertex AI Search and Conversation により、開発者はすぐに使用できる機能を使用して chatbot を数分、検索エンジンを数時間で構築、かつデプロイできます。複数の機能をエンタープライズ ワークフローに統合することを必要とするデベロッパーは、Gen App Builder API を使用して直接統合できます。 |

| デベロッパーとデータ サイエンティスト | AutoML を使用すると、独自の画像、動画、テキスト、または表形式データによるカスタムモデルを開発できます。AutoML では、モデルの開発を加速させるために、Google の Model Zoo による最も効率の良いモデル アーキテクチャの自動検索がサポートされています。したがって、モデルを構築する必要はありません。AutoML では、モデル アーキテクチャの選択、ハイパーパラメータの調整、トレーニングとサービス提供に向けたマシンのプロビジョニングなど、共通のタスクを扱います。 |

| データ サイエンティストと ML エンジニア | Vertex AI カスタム モデル ツーリングは、カスタムモデルをトレーニングして提供し、ML ワークフローの運用を可能にします。Compute Engine VM のようなセルフマネージド コンピューティングで ML ワークロードを運用できます。 |

| データ サイエンティスト、ML エンジニア | Vertex AI での生成 AI サポート(別名 genai)では、Google の大規模な生成 AI モデルにアクセスできるため、AI を活用したアプリケーションにて、モデルのテスト、調整、デプロイが可能です。 |

| SQL インターフェースに詳しいデータ エンジニア、データ サイエンティスト、データ アナリスト | BigQuery ML を使用すると、BigQuery に保存されたデータを基に SQL ベースのモデルを開発できます。 |

主なサービス

次の表に、AI と ML サービスの概要を示します。

| Google サービス | 説明 |

|---|---|

| Cloud Storage と BigQuery | ML のデータとアーティファクト用に柔軟なストレージ オプションを提供します。 |

| BigQuery ML | BigQuery 内部に格納されたデータから ML モデルを直接構築できます。 |

| Pub/Sub、Dataflow、 Cloud Data Fusion、Dataproc |

バッチおよびリアルタイムのデータの取り込みと処理をサポートします。詳細については、データ分析をご覧ください。 |

| Vertex AI | データ サイエンティストと ML エンジニアは、単一世代のプラットフォームを使用して、生成 AI から MLOps まで、あらゆる ML モデルを作成、トレーニング、テスト、モニタリング、調整、デプロイできます。 ツールには次のものが含まれます。

|

| Vertex AI Search and Conversation | ウェブサイトやエンタープライズ データ全体で使用するための chatbot と検索エンジンを構築できます。

|

| Vertex AI の生成 AI | Google の大規模生成 AI モデルにアクセスして、AI 搭載のアプリケーションで使用するためにテスト、調整、デプロイを行うことができます。Vertex AI の生成 AI は genai とも呼ばれます。

|

| 事前トレーニング済み API |

|

| AutoML | ML モデルを構築、デプロイ、スケールするためのカスタムモデル ツールを提供します。デベロッパーは、独自のデータをアップロードし、適切な AutoML サービスを使用してカスタムモデルを構築できます。

|

| AI Infrastructure | AI アクセラレータを使用して、大規模な ML ワークロードを処理できます。これらのアクセラレータを使用すると、費用対効果の高い方法でディープ ラーニング モデルや ML モデルからトレーニングし、推論を行うことができます。 GPU により、ディープ ラーニング モデルの推論や、スケールアップまたはスケールアウトによるトレーニングの費用対効果を高めることができます。Tensor Processing Unit(TPU)は、ディープ ニューラル ネットワークをトレーニングして実行するための、カスタム開発された ASIC です。 |

| Dialogflow | 会話体験を実現する仮想エージェントを提供します。 |

| Contact Center AI | 人間のエージェント向けに Agent Assist の機能を使用して、自動化されインサイトを多用したコンタクト センター体験を提供します。 |

| Document AI | ドキュメント全般、および融資関連や調達関連のドキュメントなど、具体的なドキュメントの種類に対して大規模なドキュメント理解を提供します。 |

| Lending DocAI | 担保のドキュメント処理を自動化します。規制とコンプライアンスの要件に対応しながら、処理時間を短縮し、データ キャプチャを合理化します。 |

| Procurement DocAI | 請求書や領収書などの非構造化ドキュメントを構造化データに変換して運用効率を高め、カスタマー エクスペリエンスを向上させ、意思決定に情報を提供することで、調達データのキャプチャを大規模に自動化します。 |

| 推奨事項 | パーソナライズされたおすすめ商品情報を提供します。 |

| Healthcare Natural Language AI | 医療文書を確認、分析できます。 |

| Media Translation API | 音声データからのリアルタイムの音声翻訳を有効にします。 |

データ処理

以下に挙げるデータ ストレージのベスト プラクティスを実際の環境に適用します。

データが ML 要件を満たすようにする

ML に使用するデータは、データの種類に関係なく特定の基本要件を満たす必要があります。要件には、ターゲットを予測するデータの能力、トレーニングに使用されるデータと予測に使用されるデータの粒度の整合性、トレーニング用に正確にラベル付けされたデータなどがあります。また、十分な量のデータが必要になります。詳細については、データ処理をご覧ください。

表形式データを BigQuery に保存する

表形式のデータを使用する場合は、すべてのデータを BigQuery に保存し、BigQuery Storage API を使用して、データを読み取ってください。API とのインタラクションを容易にするためには、データの読み取り方法に応じて、以下の追加ツール オプションからひとつ選んで使用してください。

- Dataflow を使用する場合は、BigQuery I/O コネクタを使用してください。

- TensorFlow や Keras を使用する場合は、BigQuery 用の tf.data.dataset リーダーを使用します。

- 画像や動画などの非構造化データを使用する場合は、すべてのデータを Cloud Storage に保存することを検討します。

入力データタイプによって、使用可能なモデル開発ツールが決定されます。事前トレーニング済みの API、AutoML、BigQuery ML は、特定の画像、動画、構造化データのユースケースに対して、より費用対効果が高く、時間効率の良い開発環境を提供できます。

ML モデルを開発するために十分なデータを確保する

利便性の高い ML モデルを開発するには、十分なデータが必要です。カテゴリを予測する場合、各カテゴリの推奨サンプル数は、機能数の 10 倍になります。より多くのカテゴリを予測するには。より多くのデータが必要です。データセットがアンバランスだと、さらに多くのデータが必要です。ラベル付けされたデータが不足している場合は、半教師あり学習を検討してください。

データセット サイズにはトレーニングや提供という意味も含みます。小規模なデータセットの場合は、Notebooks インスタンス内で直接トレーニングできます。分散トレーニングが必要な大規模なデータセットの場合は、Vertex AI custom training service を使用してください。Google 側でデータモデルをトレーニングすることを希望される場合は、AutoML を使用してください。

使用するデータを準備する

適切に準備されたデータはモデルデプロイを加速させます。データ パイプラインを構成するときは、両方のタイプのデータから一貫した結果が得られるように、バッチデータとストリーミング データの両方を処理できるようにしてください。

モデルの開発とトレーニング

以下に挙げる独自のモデル開発と、トレーニングのベスト プラクティスを実際の環境に適用します。

マネージド モデル開発またはカスタム トレーニング モデルの開発を選択する

モデルをビルドする場合、最高レベルの抽象化を検討してください。可能であれば、AutoML を使用して、開発およびトレーニングのタスクを処理してください。カスタム トレーニング済みのモデルについては、セルフマネージド オプションの代わりにスケーラビリティと柔軟性のためのマネージド オプションを選択してください。モデル開発オプションについては、推奨されるツールとプロダクトを使用するをご覧ください。

Compute Engine VM や Deep Learning VM コンテナのセルフマネージド トレーニングではなく、Vertex AI Training サービスを検討してください。JupyterLab 環境の場合は、マネージドとユーザー マネージドの両方の JupyterLab 環境を提供する Vertex AI Workbench を検討してください。詳細については、ML 開発と運用化されたトレーニングをご覧ください。

カスタム トレーニングされたモデル用にビルド済みコンテナやカスタム コンテナを使用する

Vertex AI 上のカスタム トレーニング モデルの場合、ML のフレームワークとフレームワーク バージョンに応じて、事前にビルドされたコンテナやカスタム コンテナを使用できます。事前にビルドされたコンテナは、TensorFlow、scikit-learn、PyTorch、XGBoost のいずれかのバージョン用に作成された Python トレーニング アプリケーションに使用できます。

それ以外の場合は、トレーニング ジョブ用のカスタム コンテナを作成することを選択できます。たとえば、ビルド済みのコンテナでは利用できない Python ML フレームワークを使用してモデルをトレーニングしたい場合、もしくは Python 以外のプログラミング言語を使用してトレーニングしたい場合は、カスタム コンテナを使用してください。カスタム コンテナ内で、トレーニング アプリケーションとそのすべての依存関係をイメージにプリインストールします。このイメージを使用して、トレーニング ジョブを実行します。

分散トレーニングの要件を検討する

分散トレーニング要件を検討します。TensorFlow や PyTorch のような ML フレームワークでは、複数のマシンで同一のトレーニング コードを実行できます。これらのフレームワークは、各マシンに設定された環境変数に基づき、自動で作業分担を調整します。フレームワークによっては、追加のカスタマイズが必要になる場合があります。

次のステップ

AI と ML の詳細については、以下をご覧ください。

アーキテクチャ フレームワークの他のカテゴリ(信頼性、オペレーショナル エクセレンス、セキュリティ、プライバシー、コンプライアンスなど)を確認する。

環境のサステナビリティを重視した設計

この Google Cloud アーキテクチャ フレームワークのドキュメントでは、Google Cloud でワークロードの環境のサステナビリティにアプローチする方法が要約されています。Google Cloud で二酸化炭素排出量を最小限に抑える方法に関する情報が含まれています。

二酸化炭素排出量を把握する

Google Cloud を利用した二酸化炭素排出量を把握するには、Carbon Footprint ダッシュボードを使用してください。Carbon Footprint ダッシュボードではさらに、お客様が所有する Google Cloud プロジェクトとお客様が使用するクラウド サービスへの排出量に基づいています。

詳しくは、「Google Cloud 二酸化炭素排出量を削減する」の二酸化炭素排出量を理解するをご覧ください。

最適なクラウド リージョンを選択する

二酸化炭素排出量を削減するための簡単で効果的な方法の一つは、二酸化炭素排出量の低いクラウド リージョンを選択することです。この選択をサポートするために、Google はすべての Google Cloud リージョンの二酸化炭素データを公開しています。

リージョンを選択する場合は、料金やネットワーク レイテンシなどの他の要件と排出量の削減とのバランスを取ることが必要になる場合があります。リージョンを選択するには、Google Cloud リージョン選択ツールを使用します。

詳細については、「Google Cloud 二酸化炭素排出量を削減する」の最適なクラウド リージョンを選択するをご覧ください。

最適なクラウド サービスを選択する

既存の温室効果ガス排出量を削減するために、オンプレミス VM ワークロードを Compute Engine に移行することを検討してください。

また多くのワークロードでは VM が不要であることも考慮してください。多くの場合、代わりにサーバーレス サービスを利用できます。これらのマネージド サービスは、クラウド リソースの使用量を自動的に最適化し、同時にクラウドの費用と温室効果ガス排出量を削減できます。

詳細については、「Google Cloud 二酸化炭素排出量を削減する」の最適なクラウド サービスを選択するをご覧ください。

アイドル状態のクラウド リソースを最小限に抑える

アイドル状態のリソースにより、不要なコストと排出量が発生します。リソースがアイドル状態になる一般的な原因は、次のとおりです。

- アクティブなクラウド リソースが未使用(VM インスタンスがアイドル状態であるなど)。

- リソースがオーバープロビジョニングされている(VM インスタンス数がワークロードで必要な数を超えているマシンタイプなど)。

- 効率化のための最適化が必ずしも行われていないリフト&シフト移行など、最適ではないアーキテクチャ。これらのアーキテクチャを段階的に改善することを検討してください。

クラウド リソースの無駄を最小限に抑えるための一般的な戦略は次のとおりです。

- アイドル状態のリソースまたはオーバープロビジョニングされたリソースを特定し、それらを削除するか、サイズの適正化を行う。

- アーキテクチャをリファクタリングして、より最適な設計を組み込む。

- ワークロードをマネージド サービスに移行する。

詳しくは、「Google Cloud 二酸化炭素排出量を削減する」のアイドル状態のクラウド リソースを最小限に抑えるをご覧ください。

バッチ ワークロードの排出量を削減する

二酸化炭素排出量の少ないリージョンでバッチ ワークロードを実行します。さらに削減するには、電力網の炭素強度が可能な限り低い時間帯にワークロードを実行します。

詳細については、「Google Cloud 二酸化炭素排出量を削減する」のバッチ ワークロードの排出量を削減するをご覧ください。

次のステップ

- Carbon Footprint データを使用してクラウドの二酸化炭素排出量を測定、報告、削減する方法を学習する。

- Google Cloud 二酸化炭素排出量を削減する方法を学習する。

Google Cloud アーキテクチャ フレームワーク: オペレーショナル エクセレンス

Google Cloud アーキテクチャ フレームワークのこのカテゴリでは、Google Cloud でサービスを効率的に運用する方法について説明します。ビジネス価値を実現するシステムを運用、管理、モニタリングする方法について解説します。また、オペレーショナル エクセレンスをサポートする Google Cloud プロダクトと機能についても説明します。オペレーショナル エクセレンスの原則を使用することは、信頼性の基盤を構築することに役立ちます。これは、オブザーバビリティ、自動化、スケーラビリティなどの基本的な要素を設定することで行います。

このアーキテクチャ フレームワークでは、ベスト プラクティスについて解説し、実装上の推奨事項を示しながら、オペレーショナル エクセレンスの実現に役立ついくつかのプロダクトとサービスについて説明します。このフレームワークは、ビジネスニーズに合わせて Google Cloud 環境を設計できるようにすることを目的としています。

アーキテクチャ フレームワークのオペレーショナル エクセレンスのカテゴリでは、次の方法を学習します。

- デプロイを自動化する

- モニタリング、アラート、ロギングを設定する

- クラウド サポート プロセスとエスカレーション プロセスを確立する

- 容量と割り当てを管理する

- ピーク トラフィックとリリース イベントを計画する

- 自動化の文化を創る

デプロイを自動化する

Google Cloud Architecture Framework のこのドキュメントでは、ビルド、テスト、デプロイを自動化するためのベスト プラクティスについて説明します。

自動化を行うと、コードの更新などの繰り返しのプロセスに人間が関与することによるエラーを排除することで、ビルド、テスト、デプロイの標準化が進みます。このセクションでは、自動化する際にさまざまな検査と安全確保の仕組みを使用する方法について説明します。標準化されたマシン制御のプロセスにより、デプロイが安全に適用されるようになります。また、ユーザー エクスペリエンスに大きな影響を与えることなく、必要に応じて以前のデプロイを復元する仕組みも提供されます。

コードを中央のコード リポジトリに保存する

コードは、タグ付けされたバージョン管理システムと、コード変更のロールバック機能がある中央のコード リポジトリに保存します。バージョン管理を使用すると、ファイルを整理して、チームや組織全体にわたってアクセス、更新、削除を管理できます。

さまざまな開発段階では、必要に応じてリポジトリのバージョニングやラベル付けを行います。たとえば、ラベルは、test、dev、prod などになります。

Google Cloud では、コードを Cloud Source Repositories に保存して、バージョニングや他の Google Cloud プロダクトと統合することが可能です。コンテナ化されたアプリケーションを構築する場合は、コンテナ用のマネージド レジストリである Artifact Registry を使用します。

バージョン管理の詳細については、バージョン管理をご覧ください。リポジトリを使用してトランクベース開発を実装する方法の詳細については、トランクベース開発をご覧ください。

継続的インテグレーションと継続的デプロイ(CI / CD)を使用する

デプロイは、継続的インテグレーションと継続的デプロイ(CI / CD)を使用して自動化します。CI / CD の手法は、開発チームが従っている構成や処理のパイプラインを組み合わることです。

CI / CD 手法では、ソフトウェア開発チームの生産性を改善することで、デプロイのスピードを上げます。この手法により、デベロッパーは、入念にテストされた小規模な変更をより頻繁に行うことができる一方で、変更のデプロイにかかる時間を削減できます。

CI / CD 手法の一環として、コードのビルド、テスト、デプロイのすべてのステップを自動化します。次に例を示します。

- 新しいコードがリポジトリに commit されるたびに、その commit によって自動的にビルドとテストのパイプラインが呼び出されます。

- 統合テストを自動化します。

- ビルドが特定のテスト基準を満たした後に変更がデプロイされるように、デプロイを自動化します。

Google Cloud では、CI / CD パイプラインに Cloud Build と Cloud Deploy を使用できます。

Cloud Build を使用すると、アプリケーション パッケージのパッケージ化とビルドに使用できる依存関係とバージョンを定義できます。ビルド構成をバージョニングしてすべてのビルドに一貫性を持たせ、必要に応じて以前の構成にロールバックできるようにします。

Cloud Deploy を使用すると、アプリケーションを Google Cloud の特定の環境にデプロイして、デプロイメント パイプラインを管理できます。

CI / CD の実装の詳細については、継続的インテグレーションとデプロイの自動化をご覧ください。

Infrastructure as Code でインフラストラクチャをプロビジョニングして管理する

Infrastructure as Code とは、VM などのインフラストラクチャとファイアウォール ルールなどの構成を管理する記述モデルを使用することです。Infrastructure as Code を使用すると、次のことを行えます。

- CI / CD パイプラインのデプロイ環境やテスト環境など、クラウド リソースを自動的に作成する。

- インフラストラクチャの変更を、アプリケーションの変更と同じように扱う。たとえば、構成の変更がレビュー、テスト、監査されるようにします。

- クラウド インフラストラクチャに関する信頼できる唯一の情報源を確保する。

- 必要に応じて、クラウド環境を複製する。

- 必要に応じて以前の構成にロールバックする。

この Infrastructure as Code のコンセプトは、Google Cloud のプロジェクトにも適用されます。この方法を使用すると、プロジェクト内に共有 VPC 接続や Identity and Access Management(IAM)アクセスなどのリソースを定義できます。この方法の例については、Google Cloud Project Factory Terraform モジュールをご覧ください。

Terraform などのサードパーティ ツールを使用すると、Google Cloud にインフラストラクチャを自動的に作成できます。詳細については、Terraform、Cloud Build、GitOps を使用してインフラストラクチャをコードとして管理するをご覧ください。

重要なリソースを誤って削除することや、不正に削除されることから保護するために、プロジェクト リーエン、Cloud Storage の保持ポリシー、Cloud Storage バケットのロックなどの Google Cloud の機能の使用を検討してください。

ソフトウェア デリバリーのライフサイクル全体にテストを組み込む

ソフトウェアのリリースを成功させるには、テストが不可欠です。継続的なテストにより、チームが高品質のソフトウェアを迅速に作成でき、ソフトウェアの安定性が強化されます。

テストの種類は次のとおりです。

- 単体テスト。単体テストは高速で、迅速なデプロイに役立ちます。単体テストはコードベースの一部として扱い、ビルドプロセスの一部として追加します。

- 統合テスト。統合テストは、特にスケールするように設計され、複数のサービスに依存するワークロードにとって重要です。相互接続されたサービスとの統合をテストする際は、そのテストが複雑になることがあります。

- システムテスト。システムテストは時間がかかり、複雑ですが、デプロイ前にエッジケースを特定して問題を修正するのに役立ちます。

- その他のテスト。静的テスト、負荷テスト、セキュリティ テスト、ポリシー検証テストなど、他にも実行すべきテストがあります。これらのテストは、アプリケーションを本番環境にデプロイする前に実行します。

テストを組み込むには、次のようにします。

- ソフトウェア デリバリー ライフサイクル全体にわたって、全種類のテストを継続的に実施する。

- これらのテストを自動化し、CI / CD パイプラインに含める。いずれかのテストが失敗した場合は、パイプラインを失敗させます。

- デプロイを継続的に更新し、新しいテストを追加して、デプロイの運用状態を改善する。

テスト環境の場合は、次のようにします。

- 使用するテスト環境ごとに個別の Google Cloud プロジェクトを使用する。アプリケーションごとに個別のプロジェクト環境を使用します。この分離により、本番環境のリソースと下位環境のリソースが明確に区別されます。また、ある環境内での変更が、誤って他の環境に影響を与えることがなくなります。

- テスト環境の作成を自動化する。この自動化を行う方法の 1 つは、Infrastructure as Code を使用することです。

- 合成本番環境を使用して変更内容をテストする。この環境では、エンドツーエンドのテストやパフォーマンス テストなど、アプリケーションのテストと、ワークロードに対するさまざまな種類のテストを行う、本番環境に似た環境を提供します。

継続的なテストの実装の詳細については、テストの自動化をご覧ください。

デプロイを段階的に開始する

エンドユーザーの中断を最小化、ローリング アップデート、ロールバック方法、A/B テスト方法などの重要なパラメータに基づいて、デプロイ方針を選択します。ワークロードごとにこれらの要件を評価し、ローリング アップデート、Blue/Green デプロイ、カナリア デプロイなどの実証済みの手法からデプロイ方針を選択します。

変更は、CI / CD プロセスによってのみ、本番環境に push されます。

不変のインフラストラクチャの使用を検討してください。不変のインフラストラクチャとは、変更も更新もされないインフラストラクチャのことです。新しいコードをデプロイする必要がある場合や環境内の他の構成を変更する場合は、環境全体(VM や Pod のコレクションなど)を新しい環境に置き換えます。Blue/Green デプロイは、不変のインフラストラクチャの一例です。

変更をデプロイする際には、カナリアテストを行ってシステムのエラーを確認することをおすすめします。強力なモニタリングとアラートのシステムがあれば、このタイプのモニタリングは簡単です。A/B テストやカナリアテストには、Google Cloud のマネージド インスタンス グループを使用できます。その後、必要に応じて低速ロールアウトや復元を行います。

デプロイを自動化し、デプロイ パイプラインを管理するには、Cloud Deploy の使用を検討してください。また、Google Cloud での自動デプロイとデプロイ パイプラインの作成には、Spinnaker や Tekton のようなさまざまなサードパーティ ツールも使用できます。

以前のリリースをシームレスに復元する

復元方法は、デプロイ方針の一部として定義します。デプロイメントやインフラストラクチャ構成は、以前のバージョンのソースコードにロールバックできるようにします。以前の安定したデプロイメントを復元することは、信頼性とセキュリティ両方のインシデント管理における重要なステップです。

また、デプロイ プロセスの開始前の状態に環境を復元できるようにもします。これには次のものが含まれます。

- アプリケーションのコード変更を元に戻す機能。

- 環境に加えた変更を元に戻す機能。

- 不変のインフラストラクチャを使用して、デプロイによって環境が変更されないようにする。こうすることによって、構成の変更を元に戻しやすくします。

CI / CD パイプラインをモニタリングする

自動化されたビルド、テスト、デプロイ プロセスをスムーズに実行するため、CI / CD パイプラインをモニタリングします。いずれかのパイプラインで障害が発生したことを示すアラートを設定します。パイプラインが失敗した場合に根本原因を分析できるように、パイプラインの各ステップでは適切なログ ステートメントを書き出す必要があります。

Google Cloud では、すべての CI / CD サービスが Google Cloud のオペレーション スイートに統合されています。次に例を示します。

- Cloud Source Repositories は、Pub/Sub サービスと統合されています。

- Cloud Build は、Pub/Sub と統合され、監査ログとビルドログも保存されます。ビルドログに含まれる特定のキーワードや他の多くの指標に関するアラートは、Cloud Monitoring サービスを使用して設定できます。

- Cloud Deploy は監査ログを保存します。

モニタリングとロギングの詳細については、モニタリング、アラート、ロギングを設定するをご覧ください。

アプリケーションを安全にデプロイする

アーキテクチャ フレームワークのセキュリティ、コンプライアンス、プライバシーのカテゴリにある「アプリケーションを安全にデプロイする」セクションを確認してください。

バージョン リリースのための管理ガイドラインの確立する

エンジニアによるミスを防ぎ、ソフトウェアの配信スピードを上げるには、新しいソフトウェア バージョンをリリースするための管理ガイドラインが明確に文書化されている必要があります。

リリース エンジニアは、ソフトウェアがどのように構築され、配信されているかを監督します。リリース エンジニアリング システムは、次の 4 つの手法に基づいています。

セルフサービス モード。 ソフトウェア エンジニアがよくある間違いを避けるためのガイドラインを確立します。これらのガイドラインは一般に、自動プロセスにコード化されています。

頻繁なリリース。 高速化はトラブルシューティングに役立ち、問題の修正を容易にします。頻繁なリリースは自動化された単体テストに依拠します。

ハーメティック ビルド。ビルドツールとの整合性を確保します。バージョンのビルドに使用するビルド コンパイラのバージョンを 1 か月前と比較します。

ポリシーの適用。すべての変更には、コードの審査が必要です。セキュリティを強化するための一連のガイドラインとポリシーを含めることが理想的です。ポリシーの適用により、コードのレビュー、トラブルシューティング、新しいリリースのテストが改善されます。

次のステップ

- モニタリング、アラート、ロギングを設定する(このシリーズの次のドキュメント)

- アプリケーションを安全にデプロイする(アーキテクチャ フレームワークのセキュリティ、コンプライアンス、プライバシーのカテゴリにあります)

- コンテナ構築のおすすめの方法を確認する

- 技術的機能について学習する

- アーキテクチャ フレームワークの他のカテゴリ(システム設計、セキュリティ、プライバシー、コンプライアンス、信頼性、コストの最適化、パフォーマンスの最適化)を確認する。

モニタリング、アラート、ロギングを設定する

Google Cloud アーキテクチャ フレームワークのこのドキュメントでは、モニタリング、アラート、ロギングを設定し、システムの動作に基づいて動作させる方法について説明します。有用な指標を特定して追跡し、システムに関する情報が見やすくなるようにダッシュボードを構築します。

DevOps Resource and Assessment(DORA)の研究プログラムでは、次のようにモニタリングを定義しています。

「ビジネス上の意思決定を行うことを目的として、アプリケーションやインフラストラクチャをトラックして情報を収集、分析、使用するプロセス。モニタリングは、システムと作業に関する分析情報を提供する重要な機能です。」

Monitoring により、サービス オーナーは次のことができます。

- サービスへの変更がパフォーマンスに影響する場合に、十分な情報に基づいて判断を行う。

- インシデント対応に科学的アプローチを適用する

- ビジネス目標との整合性を測定する

モニタリング、ロギング、アラートを使用すると、次のことが可能になります。

- 長期的な傾向を分析する

- 一定期間のテストを比較する

- 重要な指標に関するアラートを定義する

- 関連性の高いリアルタイム ダッシュボードを作成する

- 振り返り分析を行う。

- ビジネス主導の指標とシステムの健全性の指標の両方をモニタリングする。

- ビジネス主導の指標は、システムがビジネスをどの程度サポートしているかを理解するのに役立ちます。たとえば、指標を使用して次の対象をモニタリングします。

- ユーザーにサービスを提供するためのアプリケーションのコスト

- デザイン刷新後のサイトのトラフィック量の変化

- ユーザーがサイトで商品を購入するまでの時間

- システムの健全性の指標は、システムが正常に動作しているかどうかと、パフォーマンスが許容できるレベル内にあるかどうかを把握する助けになります。

- ビジネス主導の指標は、システムがビジネスをどの程度サポートしているかを理解するのに役立ちます。たとえば、指標を使用して次の対象をモニタリングします。

システムをモニタリングするには、次の 4 つのシグナルを使用します。

- レイテンシ。リクエストのレスポンスにかかる時間。

- トラフィック。システムに対する需要はどれくらいか。

- エラー。失敗したリクエストの割合です。失敗は、明示的(HTTP 500 など)、暗黙的(HTTP 200 の成功レスポンスが間違ったコンテンツと結合されているなど)、またはポリシー別(たとえば、commit のレスポンス時間が 1 秒である場合、1 秒を超えるリクエストはエラーになります)です。

- 飽和度。サービスの完全性。飽和度はシステムの割合の測定であり、最も制約のあるリソースを強調します(メモリ制約のあるシステムではメモリを表示し、I/O 制約のあるシステムでは I/O を表示)。

モニタリング プランを作成する

組織のミッションとその運用戦略に沿ったモニタリング プランを作成します。アプリケーション開発時のモニタリングとオブザーバビリティのプランニングを含めます。アプリケーション開発の早い段階でモニタリング プランを取り入れることで、組織のオペレーショナル エクセレンスを実現できます。

モニタリング プランには次の情報を含めます。

- オンプレミス リソースやクラウド リソースなど、すべてのシステムを含めます。

- クラウドコストのモニタリングを使用して、スケーリング イベントによって使用量が予算のしきい値を超えないようにします。

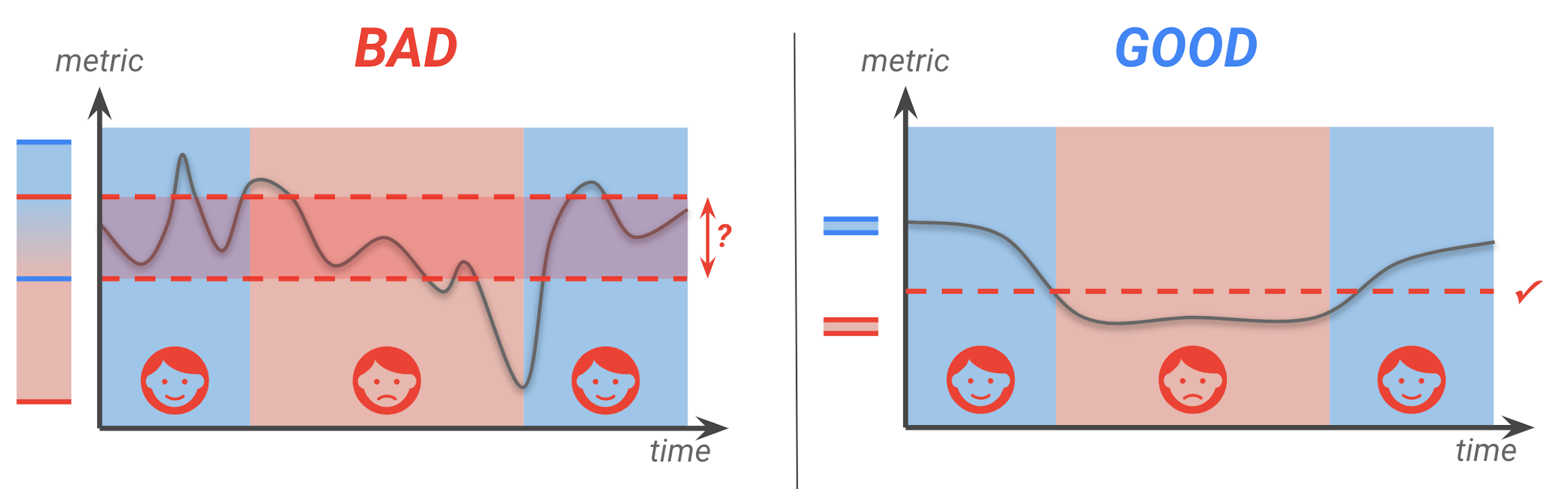

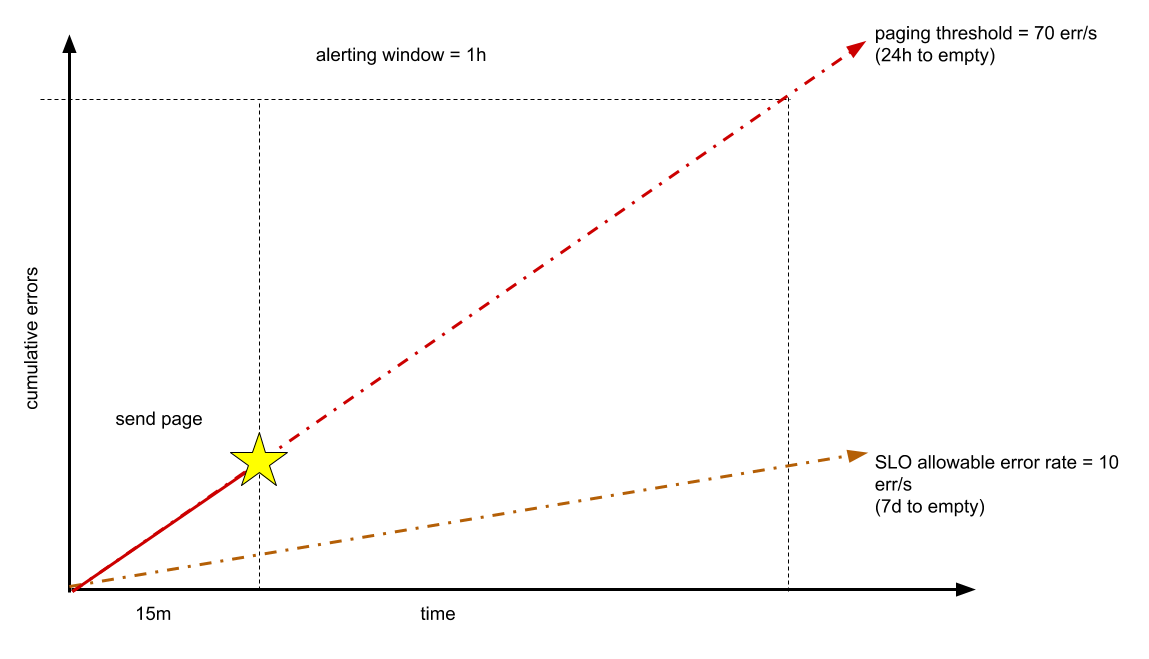

- インフラストラクチャのパフォーマンス、ユーザー エクスペリエンス、ビジネスの重要業績評価指標(KPI)を測定するさまざまなモニタリング戦略を構築します。たとえば、静的なしきい値はインフラストラクチャのパフォーマンスを測定するのには適していますが、ユーザー エクスペリエンスを正確に反映していない場合などがあります。