Anda dapat menggunakan Vertex AI SDK untuk Python untuk mengevaluasi model bahasa generatif Anda secara terprogram.

Menginstal Vertex AI SDK

Untuk menginstal evaluasi cepat dari Vertex AI SDK untuk Python, jalankan perintah berikut:

pip install --upgrade google-cloud-aiplatform[rapid_evaluation]

Untuk mengetahui informasi selengkapnya, lihat Menginstal Vertex AI SDK untuk Python.

Mengautentikasi Vertex AI SDK

Setelah menginstal Vertex AI SDK untuk Python, Anda harus melakukan autentikasi. Topik berikut menjelaskan cara melakukan autentikasi dengan Vertex AI SDK jika Anda bekerja secara lokal dan jika Anda bekerja di Colaboratory:

Jika Anda melakukan pengembangan secara lokal, siapkan Kredensial Default Aplikasi (ADC) di lingkungan lokal Anda:

Instal Google Cloud CLI, lalu initialize dengan menjalankan perintah berikut:

gcloud initBuat kredensial autentikasi lokal untuk Akun Google Anda:

gcloud auth application-default loginLayar login akan ditampilkan. Setelah Anda login, kredensial Anda akan disimpan dalam file kredensial lokal yang digunakan oleh ADC. Untuk mengetahui informasi selengkapnya tentang cara bekerja dengan ADC di lingkungan lokal, lihat Lingkungan pengembangan lokal.

Jika Anda bekerja di Colaboratory, jalankan perintah berikut di sel Colaboratory untuk melakukan autentikasi:

from google.colab import auth auth.authenticate_user()Perintah ini akan membuka jendela tempat Anda dapat menyelesaikan autentikasi.

Membuat tugas evaluasi

Karena evaluasi sebagian besar berbasis tugas menggunakan model AI generatif, evaluasi online

memperkenalkan abstraksi tugas evaluasi untuk memfasilitasi kasus penggunaan evaluasi.

Agar mendapatkan perbandingan yang adil untuk model generatif, biasanya Anda dapat menjalankan evaluasi untuk model dan meminta template terhadap set data evaluasi dan metrik terkaitnya berulang kali. Class EvalTask dirancang

untuk mendukung paradigma evaluasi baru ini. Selain itu, EvalTask memungkinkan Anda

berintegrasi dengan lancar dengan Vertex AI Experiments, yang dapat membantu melacak

setelan dan hasil untuk setiap evaluasi yang dijalankan. Vertex AI Experiments dapat

membantu mengelola dan menafsirkan hasil evaluasi, sehingga Anda dapat mengambil tindakan

dalam waktu lebih singkat. Contoh berikut menunjukkan cara membuat instance dari

class EvalTask dan menjalankan evaluasi:

from vertexai.preview.evaluation import EvalTask

eval_task = EvalTask(

dataset=DATASET,

metrics=["bleu", "rouge_l_sum"],

experiment=EXPERIMENT_NAME

)

Parameter metrics menerima daftar metrik, yang memungkinkan evaluasi simultan beberapa metrik dalam satu panggilan evaluasi.

Persiapan set data evaluasi

Set data diteruskan ke instance EvalTask sebagai DataFrame pandas, dengan setiap baris mewakili contoh evaluasi terpisah (disebut instance), dan setiap kolom merepresentasikan parameter input metrik. Lihat metrics untuk input yang diharapkan oleh setiap metrik. Kami menyediakan beberapa contoh untuk membuat set data evaluasi

untuk berbagai tugas evaluasi.

Evaluasi ringkasan

Buatlah {i>dataset<i} untuk perangkuman {i>pointwise<i} dengan metrik berikut:

summarization_qualitygroundednessfulfillmentsummarization_helpfulnesssummarization_verbosity

Dengan mempertimbangkan parameter input yang diperlukan dari metrik ini, Anda harus menyertakan kolom berikut dalam set data evaluasi kami:

instructioncontextresponse

Dalam contoh ini, kita memiliki dua instance ringkasan. Buat

kolom instruction dan context sebagai input, yang diperlukan oleh

evaluasi tugas ringkasan:

instructions = [

# example 1

"Summarize the text in one sentence.",

# example 2

"Summarize the text such that a five-year-old can understand.",

]

contexts = [

# example 1

"""As part of a comprehensive initiative to tackle urban congestion and foster

sustainable urban living, a major city has revealed ambitious plans for an

extensive overhaul of its public transportation system. The project aims not

only to improve the efficiency and reliability of public transit but also to

reduce the city\'s carbon footprint and promote eco-friendly commuting options.

City officials anticipate that this strategic investment will enhance

accessibility for residents and visitors alike, ushering in a new era of

efficient, environmentally conscious urban transportation.""",

# example 2

"""A team of archaeologists has unearthed ancient artifacts shedding light on a

previously unknown civilization. The findings challenge existing historical

narratives and provide valuable insights into human history.""",

]

Jika sudah menyiapkan respons LLM (ringkasan) dan ingin melakukan evaluasi bawa prediksi sendiri (BYOP), Anda dapat membuat input respons sebagai berikut:

responses = [

# example 1

"A major city is revamping its public transportation system to fight congestion, reduce emissions, and make getting around greener and easier.",

# example 2

"Some people who dig for old things found some very special tools and objects that tell us about people who lived a long, long time ago! What they found is like a new puzzle piece that helps us understand how people used to live.",

]

Dengan input ini, kita siap untuk membuat set data evaluasi dan

EvalTask.

eval_dataset = pd.DataFrame(

{

"instruction": instructions,

"context": contexts,

"response": responses,

}

)

eval_task = EvalTask(

dataset=eval_dataset,

metrics=[

'summarization_quality',

'groundedness',

'fulfillment',

'summarization_helpfulness',

'summarization_verbosity'

],

experiment=EXPERIMENT_NAME

)

Evaluasi pembuatan teks umum

Beberapa metrik berbasis model seperti coherence, fluency, dan safety hanya memerlukan respons model untuk menilai kualitas:

eval_dataset = pd.DataFrame({

"response": ["""The old lighthouse, perched precariously on the windswept cliff,

had borne witness to countless storms. Its once-bright beam, now dimmed by time

and the relentless sea spray, still flickered with stubborn defiance."""]

})

eval_task = EvalTask(

dataset=eval_dataset,

metrics=["coherence", "fluency", "safety"],

experiment=EXPERIMENT_NAME

)

Evaluasi Berbasis Komputasi

Metrik berbasis komputasi, seperti pencocokan persis, bleu, dan rouge, membandingkan respons dengan referensi sehingga memerlukan kolom respons dan referensi dalam set data evaluasi:

eval_dataset = pd.DataFrame({

"response": ["The Roman Senate was filled with exuberance due to Pompey's defeat in Asia."],

"reference": ["The Roman Senate was filled with exuberance due to successes against Catiline."],

})

eval_task = EvalTask(

dataset=eval_dataset,

metrics=["exact_match", "bleu", "rouge"],

experiment=EXPERIMENT_NAME

)

Evaluasi Penggunaan Alat

Untuk evaluasi penggunaan alat, Anda hanya perlu menyertakan respons dan referensi dalam set data evaluasi.

eval_dataset = pd.DataFrame({

"response": ["""{

"content": "",

"tool_calls":[{

"name":"get_movie_info",

"arguments": {"movie":"Mission Impossible", "time": "today 7:30PM"}

}]

}"""],

"reference": ["""{

"content": "",

"tool_calls":[{

"name":"book_tickets",

"arguments":{"movie":"Mission Impossible", "time": "today 7:30PM"}

}]

}"""],

})

eval_task = EvalTask(

dataset=eval_dataset,

metrics=["tool_call_valid", "tool_name_match", "tool_parameter_key_match",

"tool_parameter_kv_match"],

experiment=EXPERIMENT_NAME

)

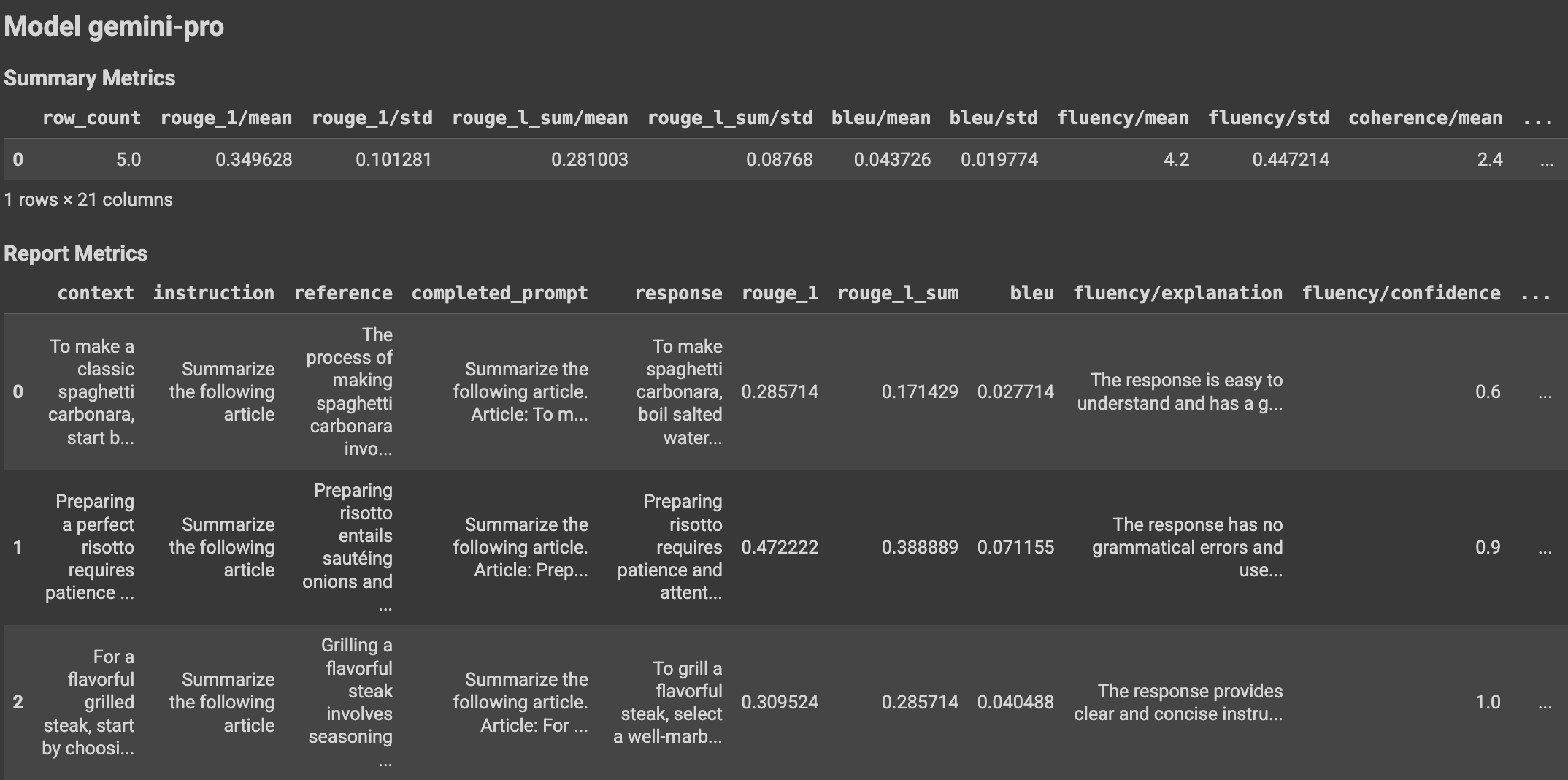

Lihat hasil evaluasi

Setelah menentukan tugas evaluasi, jalankan tugas untuk mendapatkan hasil evaluasi, seperti berikut:

eval_result: EvalResult = eval_task.evaluate(

model=MODEL,

prompt_template=PROMPT_TEMPLATE

)

Class EvalResult mewakili hasil proses evaluasi, yang

mencakup metrik ringkasan dan tabel metrik dengan instance set data evaluasi

serta metrik per instance yang sesuai. Tentukan class sebagai berikut:

@dataclasses.dataclass

class EvalResult:

"""Evaluation result.

Attributes:

summary_metrics: the summary evaluation metrics for an evaluation run.

metrics_table: a table containing eval inputs, ground truth, and

metrics per row.

"""

summary_metrics: Dict[str, float]

metrics_table: Optional[pd.DataFrame] = None

Dengan penggunaan fungsi bantuan, hasil evaluasi dapat ditampilkan di notebook Colab.

Visualisasi

Anda dapat memetakan metrik ringkasan dalam diagram batang atau radar untuk visualisasi dan perbandingan antara hasil dari proses evaluasi yang berbeda. Visualisasi ini dapat berguna untuk mengevaluasi berbagai model dan template perintah.

API evaluasi cepat

Untuk mengetahui informasi tentang API evaluasi cepat, lihat API evaluasi cepat.

Memahami akun layanan

Akun layanan digunakan oleh layanan evaluasi online untuk mendapatkan prediksi dari layanan prediksi online untuk metrik evaluasi berbasis model. Akun layanan ini otomatis disediakan pada permintaan pertama ke layanan evaluasi online.

| Nama | Deskripsi | Alamat email | Peran |

|---|---|---|---|

| Agen Layanan Rapid Eval Vertex AI | Akun layanan yang digunakan untuk mendapatkan prediksi evaluasi berbasis model. | service-PROJECT_NUMBER@gcp-sa-ENV-vertex-eval.iam.gserviceaccount.com |

roles/aiplatform.rapidevalServiceAgent |

Izin yang terkait dengan agen layanan evaluasi cepat adalah:

| Peran | Izin |

|---|---|

| Vertex AI Rapid Eval Service Agent (roles/aiplatform.rapidevalServiceAgent) | aiplatform.endpoints.predict |

Langkah selanjutnya

- Pelajari cara mulai mengevaluasi model dengan cepat.

- Pelajari evaluasi AI generatif.

- Pelajari evaluasi berpasangan berbasis model dengan pipeline AutoSxS.

- Pelajari pipeline evaluasi berbasis komputasi.

- Pelajari cara menyesuaikan model dasar.