Ray est un framework Open Source qui permet de faire évoluer des applications d'IA et Python. Ray fournit l'infrastructure nécessaire pour les opérations de calculs distribuées et de traitement en parallèle pour votre workflow de machine learning (ML).

Si vous utilisez déjà Ray, vous pouvez vous servir du même code Ray Open Source pour écrire des programmes et développer des applications sur Vertex AI avec un minimum de modifications. Vous pouvez ensuite utiliser les intégrations de Vertex AI avec d'autres services Google Cloud, tels que les prédictions de Vertex AI et BigQuery, dans votre workflow de machine learning.

Si vous utilisez déjà Vertex AI et que vous avez besoin d'un moyen plus simple de faire évoluer les ressources de calcul, vous pouvez utiliser le code Ray pour optimiser les performances de l'entraînement, du réglage des hyperparamètres, des prédictions et des étapes de diffusion en ligne.

Workflow d'utilisation de Ray sur Vertex AI

Utilisez Colab Enterprise et le SDK Vertex AI pour Python pour vous connecter au cluster Ray.

| Étapes | Description |

|---|---|

| 1. Configurez Ray sur Vertex AI. | Configurez votre projet Google, installez la version du SDK Vertex AI pour Python qui inclut les fonctionnalités du client Ray, puis configurez un réseau d'appairage de VPC, ce qui est facultatif. |

| 2. Créer un cluster Ray sur Vertex AI | Créez un cluster Ray sur Vertex AI. |

| 3. Développer une application Ray sur Vertex AI | Connectez-vous à un cluster Ray sur Vertex AI et développez une application. |

| 4. (Facultatif) Utiliser Ray sur Vertex AI avec BigQuery | Lisez, écrivez et transformez des données avec BigQuery |

| 5. (Facultatif) Déployer un modèle sur Vertex AI et obtenir des prédictions | Déployez un modèle sur un point de terminaison en ligne Vertex AI et obtenez des prédictions. |

| 6. Surveiller votre cluster Ray sur Vertex AI | Surveillez les journaux générés dans Cloud Logging et les métriques dans Cloud Monitoring. |

| 7. Supprimer un cluster Ray sur Vertex AI | Supprimez un cluster Ray sur Vertex AI pour éviter que des frais ne vous soient facturés. |

Présentation

Les clusters Ray sont intégrés pour garantir la disponibilité de la capacité pour les charges de travail de ML critiques ou pendant les périodes de pointe. Contrairement aux tâches personnalisées, où le service d'entraînement libère la ressource une fois la tâche terminée, les clusters Ray restent disponibles jusqu'à leur suppression.

Remarque : Utilisez des clusters Ray de longue durée dans les scénarios suivants :

- Si vous envoyez le même job Ray plusieurs fois et que vous pouvez bénéficier de la mise en cache des données et des images en exécutant les jobs sur les mêmes clusters Ray de longue durée.

- Si vous exécutez de nombreux jobs Ray de courte durée dans lesquels le temps de traitement réel est plus court que temps de démarrage des jobs, il peut être intéressant de disposer d'un cluster de longue durée.

Les clusters Ray sur Vertex AI peuvent être configurés avec une connectivité publique ou privée. Les schémas suivants illustrent l'architecture et le workflow de Ray sur Vertex AI. Pour en savoir plus, consultez la section Connectivité publique ou privée.

Architecture avec connectivité publique

Créez le cluster Ray sur Vertex AI à l'aide des options suivantes :

a. Utilisez la console Google Cloud pour créer le cluster Ray sur Vertex AI.

b. Créez le cluster Ray sur Vertex AI à l'aide du SDK Vertex AI pour Python.

Connectez-vous au cluster Ray sur Vertex AI pour le développement interactif à l'aide des options suivantes :

a. Utilisez Colab Enterprise dans la console Google Cloud pour une connexion fluide.

b. Utilisez n'importe quel environnement Python accessible à Internet.

Développez votre application et entraînez votre modèle sur le cluster Ray sur Vertex AI :

Utilisez le SDK Vertex AI pour Python dans l'environnement de votre choix (Colab Enterprise ou n'importe quel notebook Python).

Écrivez un script Python à l'aide de l'environnement de votre choix.

Envoyez un job Ray au cluster Ray sur Vertex AI à l'aide du SDK Vertex AI pour Python, de la CLI Ray Job ou de l'API Ray Job Submission.

Déployer le modèle entraîné sur un point de terminaison Vertex AI en ligne pour la prédiction en direct.

Utilisez BigQuery pour gérer vos données.

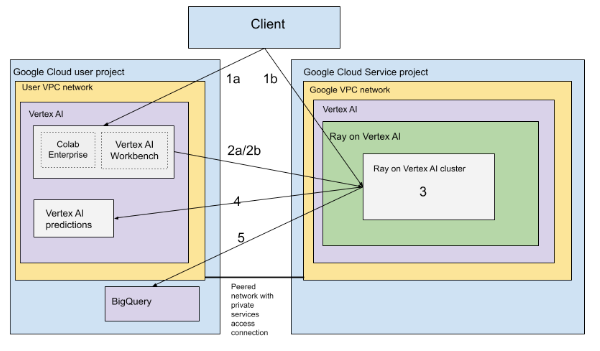

Architecture avec VPC

Le schéma suivant présente l'architecture et le workflow de Ray sur Vertex AI après la configuration de votre projet Google Cloud et de votre réseau VPC, ce qui est facultatif :

Configurez votre (a) projet Google et votre (b) réseau VPC.

Créez le cluster Ray sur Vertex AI à l'aide des options suivantes :

a. Utilisez la console Google Cloud pour créer le cluster Ray sur Vertex AI.

b. Créez le cluster Ray sur Vertex AI à l'aide du SDK Vertex AI pour Python.

Connectez-vous au cluster Ray sur Vertex AI via un réseau VPC appairé à l'aide des options suivantes :

Utilisez Colab Enterprise dans la console Google Cloud.

Utilisez un notebook Vertex AI Workbench.

Développez votre application et entraînez votre modèle sur le cluster Ray sur Vertex AI à l'aide des options suivantes :

Utilisez le SDK Vertex AI pour Python dans l'environnement de votre choix (notebook Colab Enterprise ou Vertex AI Workbench).

Écrivez un script Python à l'aide de l'environnement de votre choix. Envoyez un job Ray au cluster Ray sur Vertex AI à l'aide du SDK Vertex AI pour Python, de la CLI du job Ray ou du tableau de bord Ray.

Déployez le modèle entraîné sur un point de terminaison Vertex AI en ligne pour les prédictions.

Utilisez BigQuery pour gérer vos données.

Tarifs

Les tarifs de Ray sur Vertex AI sont calculés comme suit :

Les ressources de calcul que vous utilisez sont facturées en fonction de la configuration de machine que vous sélectionnez lors de la création de votre cluster Ray sur Vertex AI. Pour connaître les tarifs de Ray sur Vertex AI, consultez la page des tarifs.

Lorsque vous effectuez des tâches à l'aide du cluster Ray sur Vertex AI, les journaux sont automatiquement générés et facturés en fonction des tarifs de Cloud Logging.

Si vous déployez votre modèle sur un point de terminaison pour les prédictions en ligne, consultez la section Prédiction et explications de la page "Tarifs de Vertex AI."

Si vous utilisez BigQuery avec Ray sur Vertex AI, consultez les tarifs de BigQuery.